(Stimme: George “von” Eleven Labs)

Immanuel Kant in seinem Essay “Beantwortung der Frage: Was ist Aufklärung?” aus dem Jahr 1784, also vor 240 Jahren:

“Unmündigkeit ist das Unvermögen, sich seines Verstandes ohne Leitung eines anderen zu bedienen. Selbstverschuldet ist diese Unmündigkeit, wenn die Ursache derselben nicht am Mangel des Verstandes, sondern der Entschließung und des Mutes liegt, sich seiner ohne Leitung eines anderen zu bedienen.”

Man kann sich nun fragen, war es das mit dem Klimaschutz und einer Transition zu einer “Zero CO₂ Industry“. Trump und eine internationale nationalistische Rechte (kann man das so sagen?), die den Klimawandel als Hoax erachten und große Teile der Bevölkerung in den Industrienationen, die meinen, mit dem Klima sei es jetzt mal gut, schließlich haben wir noch andere K-Probleme (Krieg und KI). Und in der Tat sind die beiden anderen Ks ebenso starke Gründe obigen Titel zu begründen.

Ich beschränke mich aber auf den Klimawandel, der keine Rücksicht auf die anderen K-Probleme nehmen wird. Auch wenn leider alle K-Probleme irgendwie unerbittlich sind, was nicht bedeutet, dass sie nicht zu meistern wären. Es ist immer noch viel in Menschen’s Hand. Aber die Optionen den Gefahren zu begegnen, sie schwinden.

Natürlich habe ich keine Glaskugel, und wenn ich sie hätte, würde ich sie an einem sicheren Ort nachhaltig entsorgen, aber auch ohne sie kann ich mit hoher Sicherheit sagen, dass der Klimawandel und seine Folgen uns noch lange, sehr lange beschäftigen werden.

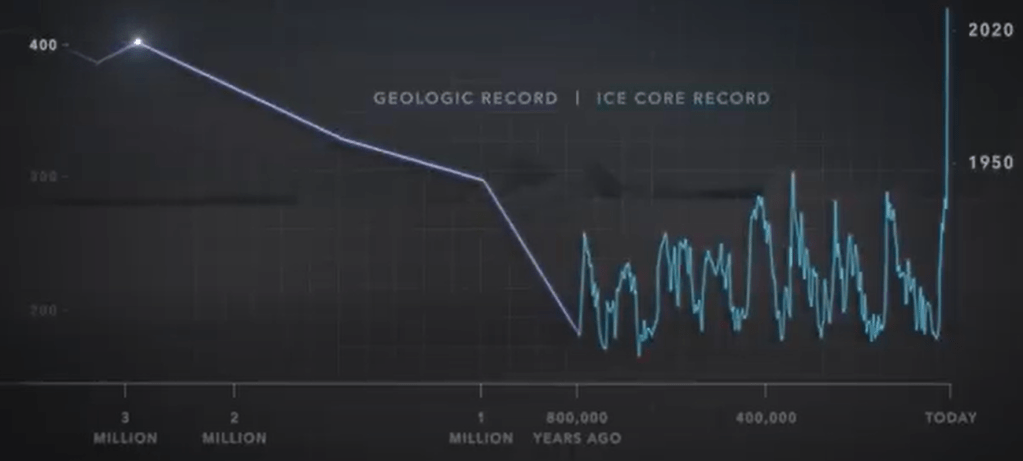

Ganz nüchtern betrachtet entscheidet die Menschheit in den nächsten 10-30 Jahren, wie die Welt in den nächsten 800.000 Jahren abläuft.

Wie konnte es zu so einem Missverhältnis kommen, dass nur wenige Jahrzehnte über 800.000 Jahre signifikanten Einfluss auf den Lauf der Dinge haben werden? Korrekter sollte ich natürlich sagen, dass die letzten 250 Jahre uns in diese Ausgangssituation brachten.

Im Folgenden erkläre ich noch einmal, warum die CO₂-Konzentration, die Klimaveränderung in den letzten 250 Jahren so stark und schnell vorangetrieben hat.

Ich bin 1966 geboren worden.

1966: lagen die weltweiten CO₂-Emissionen aus fossilen Brennstoffen von Haushalten und Industrie bei etwa 11,2 Milliarden Tonnen pro Jahr.

2023: Die Emissionen stiegen auf einen Rekordwert von 37,1 Milliarden Tonnen pro Jahr, was einem Anstieg von über 331 % gegenüber 1966 entspricht.

2024 (Prognose): Für 2024 wird ein weiterer Anstieg um 0,8 % auf 37,4 Milliarden Tonnen erwartet.

Der CO₂-Gehalt der Atmosphäre im Jahr 1966 lag bei etwa 322 ppm (parts per million). Zum Vergleich: Vor der Industrialisierung (ca. 1750) betrug der Wert etwa 280 ppm.

Bemerkung: Die obigen Werte stammen aus der Luftextraktion von Eisbohrkernen aus der Antarktis. Je tiefer man bohrt, umso mehr geht man zeitlich in die Vergangenheit.

Entwicklung bis heute:

- 1966: 322 ppm

- 2023: 419,3 ppm (Anstieg um rund 98 ppm)

- Der jährliche Anstieg lag in den 1960er Jahren bei etwa 0,8 ppm/Jahr, während er heute bei etwa 2,5 bis 3 ppm/Jahr liegt.

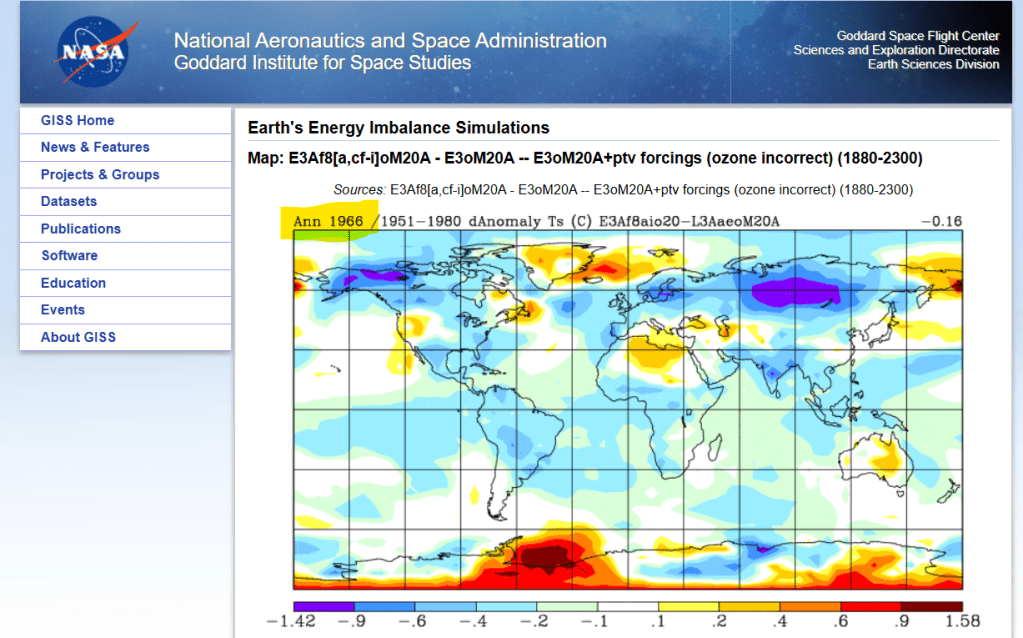

Die NASA bietet ein Simulationstool an, mit dem man die globale Temperaturverteilung eines Jahres im Vergleich zu einer Referenzzeitperiode sich anschauen kann.

https://data.giss.nasa.gov/modelE/imbalance/

Es verwundert nicht, dass es 1966 im Vergleich zur mittleren globalen Temperatur über die Jahre 1951-1980 deutlich kälter war, und zwar auch da, wo man es vermutet, in Sibirien, Alaska und in der Antarktis. Aber über Grönland und Island sieht man schon deutliche Temperaturerhöhungen. Insgesamt deckt sich das mit meiner persönlichen Erfahrung, dass ich bis zu meinem 13. Lebensjahr in Düsseldorf regelmäßig Schnee erlebte, mit einer geschlossenen Schneedecke von 3 bis 4 Wochen mit einer Höhe um die 5 cm. Mein Sohn erfuhr nur 2009 einmal ein solches Erlebnis in Düsseldorf. Als es dieses Jahr zumindest für eine Woche mal wieder mehr Schnee in Düsseldorf gab, zelebrierte mein Sohn den Schneefall auf unserem Balkon in der Hollywoodschaukel. Es war für ihn ein ganz besonderer Moment.

Dass es in Düsseldorf aber auch mal wirklich kälter war, dokumentiert das folgende Foto vom Stadtarchiv Düsseldorf aus dem Jahr 1942 (ein völlig zugefrorener Rhein mit Blick auf die Südbrücke, heute Kardinal Frings Brücke):

https://rp-online.de/nrw/staedte/duesseldorf/als-der-rhein-in-duesseldorf-zufror_bid-12584661#12

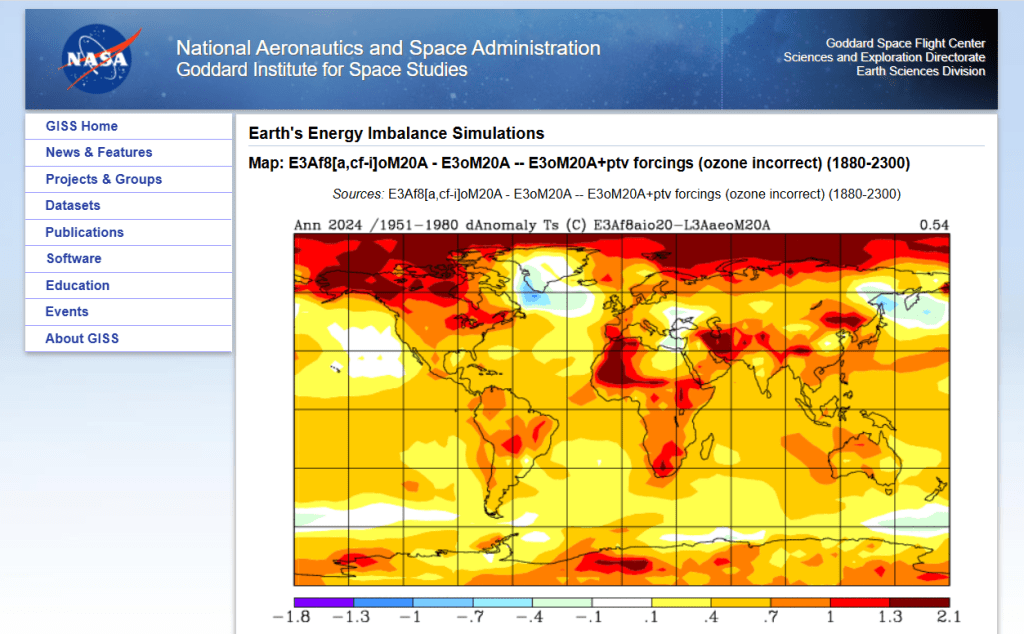

Es sollte nun ebenfalls nicht erstaunen, dass die Simulation der globalen Temperaturverteilung von 2024 gegenüber dem Mittel von 1951 bis 1980 farblich anders ausfällt, deutlich anders.

Auch die Skala der Temperaturveränderung reicht jetzt im Bereich der Temperaturzunahme bis 2.1 statt 1.58 Grad Celsius. Am deutlichsten erkennbar ist die starke Temperaturerhöhung im Nordpolarbereich. Dies erklärt auch die immer heftigeren Waldbrände in Kanada oder in der Tundra in Russland. Aber auch die Antarktis ist jetzt ganz in roten/gelblichen Tönen gefasst.

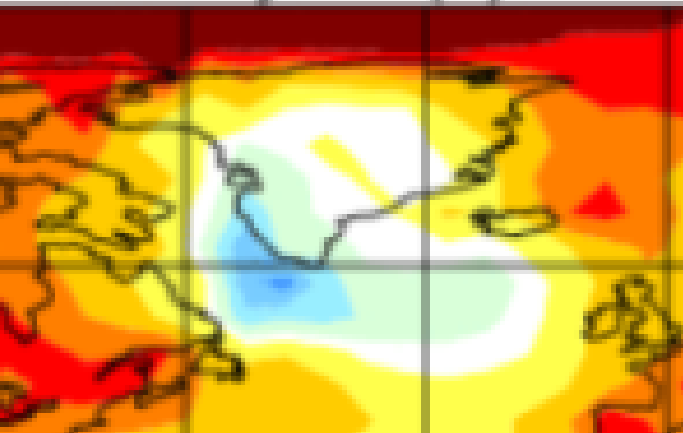

Ein markanter Bereich verhält sich gegen den Trend und ist abgekühlt. Die Wissenschaftler sprechen vom sogenannten Cold Blob.

Gemeint ist der Bereich südlich von Grön- und Island, westlich der Britischen Inseln.

Auf dieses Gebiet kommen wir noch später zu sprechen.

Warum ist es zu dieser globalen Temperaturerhöhung gekommen, und was hat CO₂ damit zu tun? Die Antwort ist in der Überschrift obiger Diagramme zu lesen:

The Earths’s Energy Imbalance

Was ist damit gemeint?

Leider lässt sich das nicht ohne Physik und Mathematik erklären. Die Natur spricht nur in der Form der Mathematik zu uns, warum sie keine leichtere Sprache gewählt hat, bleibt ihr Geheimnis.

Ein wesentlicher Begriff zur Klärung dieses Bilanzproblems, das sich auch nicht durch doppelte Buchführung lösen lässt, ist das thermische Gleichgewicht.

Ein zugegebenermaßen nicht einfacher Begriff in der Physik, in dem die beiden Hauptsätze der Thermodynamik (1. Hauptsatz=Energieerhaltungssatz in geschlossenen Systemen, 2. Hauptsatz=Anstieg der Entropie) fundamental eingehen.

Nähern wir uns diesem Thema bei einer Tasse Kaffee mit einem bekannten Alltagsphänomen:

Ein frisch aufgebrühter Kaffee verführt zunächst dazu, dass man zu schnell den ersten Schluck nimmt, um festzustellen, dass er verdammt heiß ist. Doch mit zunehmender Zeit kühlt er angenehm ab, bis man beim letzten Schluck merkt, dass der Kaffee kalt ist.

Aber was ist Wärme und wie funktioniert das Abkühlen?

Wärme lässt sich in zwei wesentliche Aspekte aufteilen:

Wärme als Bewegungsenergie von Teilchen:

Wärme ist die Energie, die in der Bewegung von Atomen und Molekülen steckt. Je schneller sich diese Teilchen bewegen, desto mehr Wärmeenergie haben sie. Diese Bewegungsenergie nehmen wir als Temperatur wahr. Je höher die Temperatur, desto schneller bewegen sich die Teilchen.

Elektromagnetische Strahlung: Durch die Bewegung der Teilchen verändert sich auch die Verteilung der Elektronen in den Atomen oder Molekülen. Diese Veränderung führt dazu, dass Wärme in Form von elektromagnetischer Strahlung abgegeben wird, die oft als Infrarotstrahlung bezeichnet wird. Das ist die Strahlung, die wir spüren, wenn wir etwa die Wärme der Sonne auf unserer Haut wahrnehmen.

Eine mit heißem Kaffee gefüllte Tasse hat anfangs eine Außentemperatur von etwa 90 Grad Celsius. Wenn sie auf dem Tisch in einem Raum steht, gibt sie ihre Wärme an die Umgebung ab. Dies geschieht durch die Abstrahlung von Wärmestrahlung, die in Form von Teilchen, sogenannten Photonen, transportiert wird.

Wärme und Licht sind beide Formen elektromagnetischer Strahlung, die als ein Strom von Photonen auftreten. Diese Teilchen bewegen sich mit verschiedenen Frequenzen und Energien, je nachdem, um welche Art von Strahlung es sich handelt – von der unsichtbaren Infrarotstrahlung (Wärme) bis hin zum sichtbaren Licht.

Die mit heißem Kaffee gefüllte Tasse sendet nicht nur Photonen, also Wärmestrahlung, in die Umgebung, sondern empfängt auch Photonen aus ihrer Umgebung. Da der Raum eine bestimmte Zimmertemperatur hat, gibt er ebenfalls Wärmestrahlung ab, die von der Tasse aufgenommen wird. Es findet also ein ständiger Austausch von Energie zwischen der Tasse und ihrer Umgebung statt.

Am Ende dieses Prozesses – das wissen wir aus Erfahrung – erreicht der Kaffee nicht eine “absolute Kälte”, sondern die gleiche Temperatur wie die Umgebungsluft. Das ist in diesem Fall die Zimmertemperatur, die deutlich niedriger ist als die anfängliche Temperatur des Kaffees von 90 Grad Celsius.

Wenn der Kaffee schließlich die gleiche Temperatur wie die Zimmertemperatur erreicht hat, besteht ein Gleichgewicht im Austausch von Wärmestrahlung. Die Anzahl der Wärmeteilchen (Photonen), die von der Tasse und dem Kaffee aufgenommen werden, entspricht dann genau der Anzahl der Wärmeteilchen, die die Tasse und der Kaffee abgeben.

Dieses Phänomen wird als thermodynamisches Gleichgewicht bezeichnet. In diesem Zustand herrscht kein Netto-Energiefluss mehr zwischen der Tasse und ihrer Umgebung. Messtechnisch bedeutet das, dass die Temperatur der Tasse und des Kaffees identisch mit der Umgebungstemperatur ist – in diesem Fall der Zimmertemperatur.

Aus dem zweiten Hauptsatz der Thermodynamik, der das Ansteigen der Entropie beschreibt, kann abgeleitet werden, dass Wärme stets von Objekten mit höherer Temperatur zu Objekten mit niedrigerer Temperatur fließt. Objekte mit höherer Temperatur strahlen mehr Energie in Form von Photonen ab, und diese Energie “fließt” in Richtung der kälteren Umgebung. Dieser Prozess geschieht immer in der Richtung, die zu einer größeren Entropie führt, also zu einer gleichmäßigeren Verteilung der Energie.

Wärme fließt daher niemals spontan (von selbst) von einem kälteren zu einem wärmeren Objekt, sondern immer vom Wärmeren zum Kälteren, bis ein thermodynamisches Gleichgewicht erreicht ist.

Schauen wir uns jetzt den Wärme- und Strahlungsprozess zwischen Sonne und Erde an. Die Sonne ist etwa 150 Millionen Kilometer von der Erde entfernt. Das Licht, das sie abstrahlt, benötigt rund acht Minuten, um diese Entfernung zu überwinden und die Erde zu erreichen.

Doch was “sieht” die Sonne dabei? Aus der Perspektive der Sonne erscheint die Erde als eine kreisförmige Scheibe, die in die Strahlungsfront der Sonnenstrahlen ein “Loch” schneidet. Diese Fläche, die die Erde von der Sonnenstrahlung absorbiert, entspricht der Querschnittsfläche eines Kreises mit dem Radius der Erde. Mathematisch lässt sich diese Fläche durch die Formel πr² beschreiben, wobei r der Radius der Erde ist.

Diese Fläche definiert die Menge der Sonnenenergie, die die Erde direkt empfängt und anschließend weiterverarbeitet, sei es durch Reflexion, Absorption oder Umwandlung in Wärme.

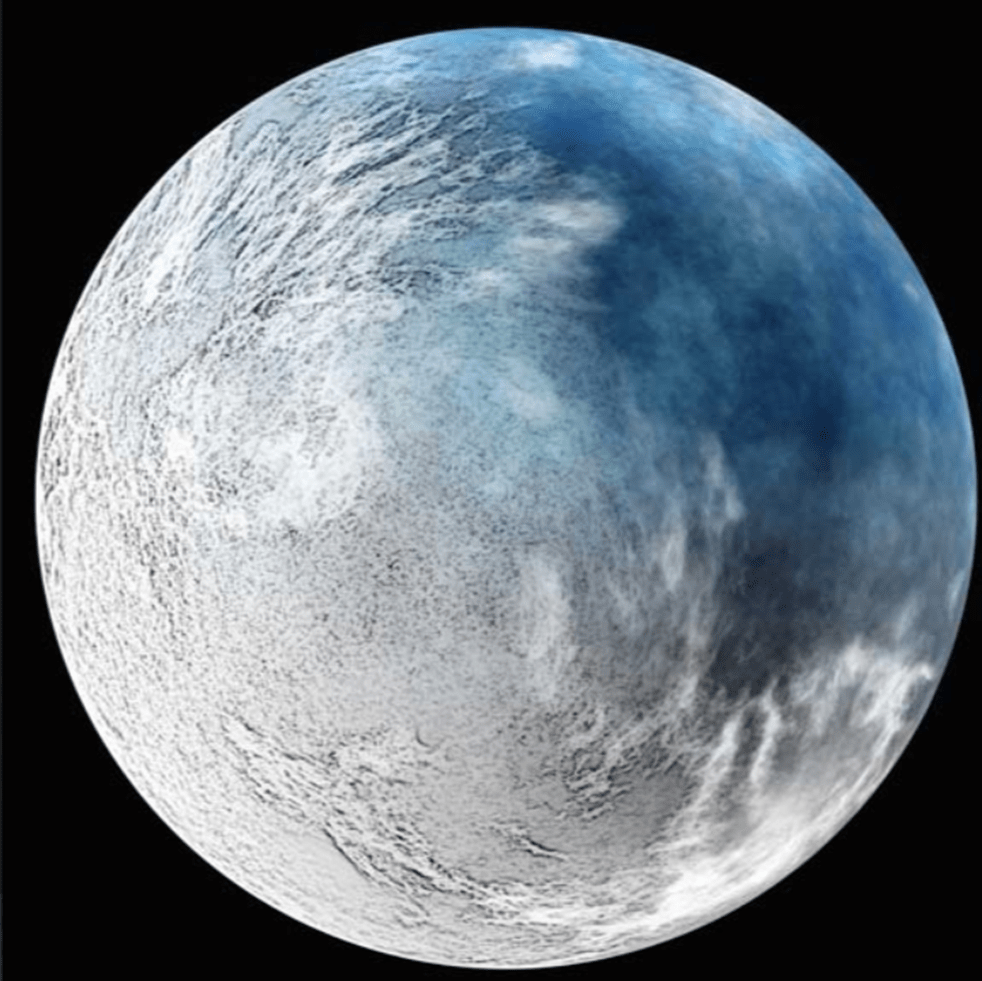

Die Sonne sieht also die Erde so:

Die Strahlungsdichte, die die Sonne auf Höhe der Erde abstrahlt, wird durch die sogenannte Solarkonstante S definiert. Diese gibt an, wie viel Energie pro Quadratmeter auf eine senkrechte Fläche außerhalb der Erdatmosphäre trifft. Die Solarkonstante beträgt etwa 1361 Watt pro Quadratmeter.

Da die Erde die Strahlung der Sonne nicht vollständig absorbiert, sondern auch einen Teil davon reflektiert, wird dies durch den Albedofaktor α berücksichtigt. Der Albedo-Wert beschreibt den Anteil der reflektierten Strahlung. Für die Erde liegt dieser Wert bei etwa 30% (also α ≈ 0,3), was bedeutet, dass ein Drittel der Sonnenstrahlung wieder ins All zurückgeworfen wird.

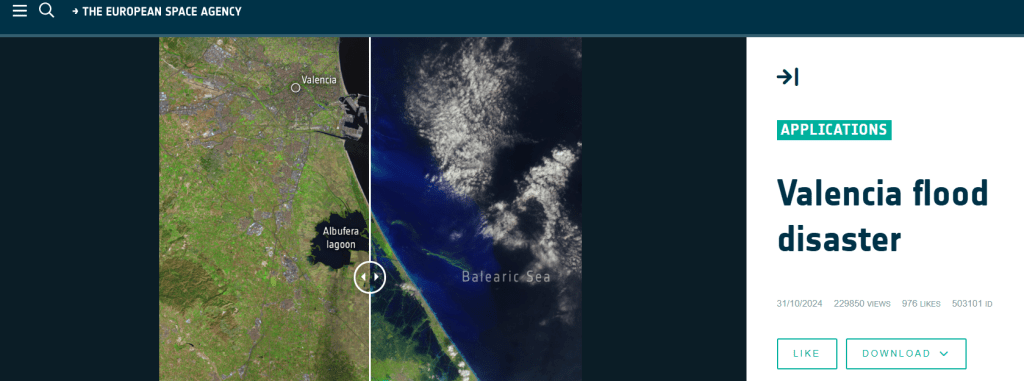

Die tatsächlich aufgenommene Energie der Erde lässt sich mathematisch durch die folgende Gleichung ausdrücken:

Dabei ist:

- S die Solarkonstante (Strahlungsdichte der Sonne),

- α der Albedofaktor (Reflektionsfaktor),

- πr² die Querschnittsfläche der Erde, die von der Sonnenstrahlung getroffen wird,

- (1 – α) der Anteil der Strahlung, der von der Erde absorbiert wird.

Diese Formel beschreibt die effektive Menge der Sonnenenergie, die die Erde erreicht und letztlich das Klima und die Temperatur der Erde beeinflusst.

Doch die Erde empfängt nicht nur Strahlung im sichtbaren Bereich von der Sonne, sondern gibt – ähnlich wie die warme Tasse – auch selbst Strahlung ab. Diese Abstrahlung erfolgt als Infrarotstrahlung in den Weltraum. Bereits im 19. Jahrhundert haben die Physiker Josef Stefan und Ludwig Boltzmann eine analytische Beziehung dafür entwickelt: das Stefan-Boltzmann-Gesetz.

Dieses Gesetz beschreibt, dass die Strahlungsleistung eines warmen Körpers proportional zur vierten Potenz seiner Temperatur ist. Mathematisch ausgedrückt:

Dabei ist:

- P die Strahlungsleistung (in Watt),

- σ die Stefan-Boltzmann-Konstante (ca. 5,67 × 10⁻⁸ W/(m²·K⁴)),

- A die Oberfläche des strahlenden Körpers,

- T die absolute Temperatur des Körpers (in Kelvin).

Dieses Gesetz zeigt, dass ein Körper, der wärmer ist, wesentlich mehr Energie abstrahlt. Die Erde befindet sich im Gleichgewicht zwischen der absorbierten Strahlung von der Sonne und der abgestrahlten Wärmestrahlung, wodurch sich letztlich ihre Oberflächentemperatur einstellt.

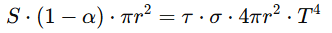

Setzt man die von der Sonne empfangene Energie gleich mit der von der Erde abgestrahlten Energie, beschreibt dies den Zustand des thermodynamischen Gleichgewichts. In diesem Zustand bleibt die Temperatur der Erde stabil, da keine Netto-Energieänderung mehr stattfindet. Die Gleichung dafür lautet:

Dabei ist:

- S die Solarkonstante (Strahlungsdichte der Sonne),

- (1 – α) der Anteil der absorbierten Strahlung (mit α als Albedofaktor, ca. 0,3),

- πr² die Querschnittsfläche der Erde, die Sonnenstrahlung empfängt,

- σ die Stefan-Boltzmann-Konstante (ca. 5,67 × 10⁻⁸ W/(m²·K⁴)),

- 4πr² die gesamte Oberfläche der Erde, die Wärmestrahlung abgibt (Fläche der Erdkugel, denn auch die dunkle Nachthälfte gibt die Erdwärme Strahlung ab),

- T die effektive Strahlungstemperatur der Erde (in Kelvin).

Erklärung:

Die linke Seite der Gleichung beschreibt die Energie, die die Erde von der Sonne absorbiert, während die rechte Seite die Energie darstellt, die die Erde durch Wärmestrahlung wieder abstrahlt.

Da sich die Fläche der empfangenden und abstrahlenden Seiten unterscheidet (Querschnitt vs. Oberfläche), ist die 4 in der Formel ein geometrischer Faktor, der die Kugelgestalt der Erde berücksichtigt.

Durch Umstellen der Formel kann man die effektive Strahlungstemperatur T der Erde berechnen:

Diese Temperatur liegt ohne Treibhauseffekt bei etwa -18 °C und zeigt, wie wichtig die Atmosphäre für die tatsächliche Durchschnittstemperatur der Erde ist.

Doch so kalt, wie es die theoretische Berechnung von -18 °C vorhersagt, ist es auf der Erde nicht. Zumindest derzeit nicht. Es gab jedoch schon Epochen, in denen die Erde tatsächlich so kalt war. Vor etwa 700 Millionen Jahren beispielsweise herrschte die sogenannte Schneekugel-Erde: Fast die gesamte Erdoberfläche war mit Eis bedeckt, was die Lebensbedingungen extrem einschränkte.

Warum ist es heute wärmer? Diese Frage führt uns zur Rolle der Atmosphäre und des Treibhauseffekts, der die Erde auf einem für Leben geeigneten Temperaturniveau hält. Ohne diese natürliche Wärmeschicht wäre die durchschnittliche Temperatur der Erde bei -18 °C – ein Wert, bei dem kein Leben, wie wir es kennen, existieren könnte.

Diese Temperatur ist eine globale mittlere Durchschnittstemperatur und berücksichtigt weder lokale Schwankungen noch extreme Bedingungen. Klar ist jedoch: Bei solch eisigen Verhältnissen könnten komplexe Lebensformen nicht überleben. Es sind die Treibhausgase in der Atmosphäre, die diese lebensfeindlichen Bedingungen abwenden, indem sie einen Teil der Wärmestrahlung zurück zur Erdoberfläche reflektieren und die Temperaturen stabilisieren.

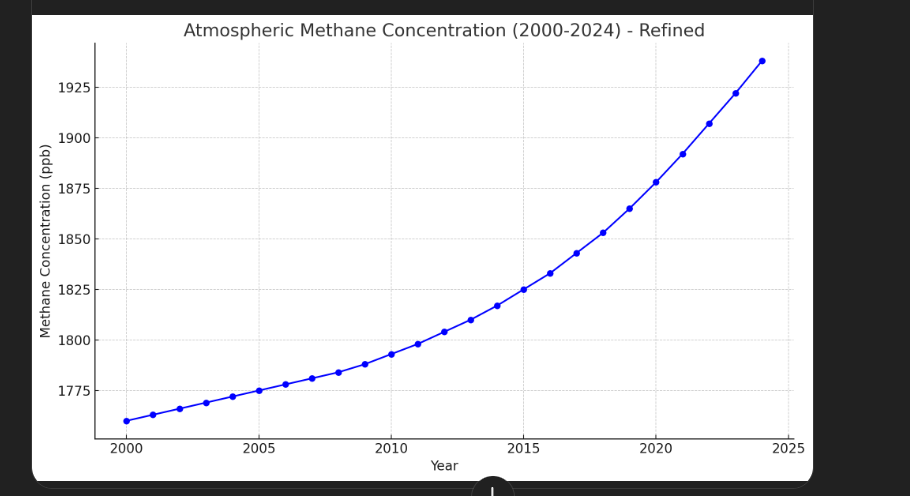

Die Erde ist aber von einer Atmosphäre umgeben, die sogenannte Klimagase enthält. Zu diesen zählen vor allem Kohlendioxid (CO₂) und Methan (CH₄). Diese Gase besitzen die besondere Eigenschaft, die Wärmestrahlung teilweise zurückzuhalten oder zu reflektieren. Dadurch bleibt die Wärme länger in der Atmosphäre, und die Erde wird insgesamt wärmer – ein Effekt, den wir als Treibhauseffekt kennen.

Um diesen Einfluss mathematisch zu berücksichtigen, fügen wir der Abstrahlungsenergie der Erde, die durch das Stefan-Boltzmann-Gesetz beschrieben wird:

einen zusätzlichen Faktor τ hinzu. Dieser Faktor (ausgesprochen “Tau”) beschreibt, wie viel der abgestrahlten Energie tatsächlich in den Weltraum entweicht. Werte von τ kleiner als 1 bedeuten, dass ein Teil der Energie durch die Klimagase in der Atmosphäre zurückgehalten wird. Die modifizierte Gleichung für die Abstrahlungsenergie lautet daher:

Gleichgewicht von einfallendem und ausgehendem Energiefluss

Für das thermische Gleichgewicht bei vorhandener Atmosphäre gilt nun:

Wenn τ = 1 ist, gibt es keinen Treibhauseffekt, und die Temperatur der Erde liegt bei den berechneten -18 °C.

Ein kleinerer Wert für τ (z. B. durch höhere Konzentrationen von Treibhausgasen) bedeutet, dass weniger Energie in den Weltraum entweicht.

Betrachtet man den modifizierten Energiefluss, der nun den Faktor τ bei der abgestrahlten Energie berücksichtigt, wird deutlich: Die linke Seite der Gleichung, die die von der Sonne empfangene Energie beschreibt, bleibt unverändert. Die einfallende Energie hängt ausschließlich von der Solarkonstante, dem Albedo-Wert und der Querschnittsfläche der Erde ab und bleibt konstant.

Auf der rechten Seite jedoch, die die abgestrahlte Energie der Erde beschreibt, kommt der Faktor τ ins Spiel. Da τ < 1 ist, wird die abgestrahlte Energie der Erde reduziert, während alle anderen Größen wie die Stefan-Boltzmann-Konstante und die Erdoberfläche konstant bleiben.

Um die Gleichung dennoch zu erfüllen, bleibt nur eine Möglichkeit: Die Temperatur der Erde (T) muss steigen. Eine höhere Temperatur bewirkt, dass die Erde mehr Wärmestrahlung (Photonen) abgibt, da die Strahlungsleistung gemäß dem Stefan-Boltzmann-Gesetz proportional zur vierten Potenz der Temperatur ist. Erst durch diesen Temperaturanstieg kann das thermodynamische Gleichgewicht wieder erreicht werden, bei dem die einfallende Energie von der Sonne gleich der abgestrahlten Energie der Erde ist.

Zusammengefasst bedeutet dies:

Der Faktor τ, der den Treibhauseffekt beschreibt, reduziert die Effizienz der Abstrahlung.

Um diese Einschränkung zu kompensieren, muss die Erde heißer werden, damit sie genügend Wärmestrahlung erzeugt, um das Gleichgewicht zu halten.

Dieser Mechanismus erklärt, warum höhere Konzentrationen von Treibhausgasen unweigerlich zu einem Temperaturanstieg auf der Erde führen.

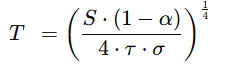

Formt man die obige thermische Gleichgewichtsformel zwischen Sonne und Erde wieder zu Temperatur auf der Erde um, erhält man:

Plottet man diese Temperaturfunktion und gibt für α = 0,3 ein, für τ = 0,6 erhält man 16 Grad (also 34°C wärmer als ohne Atmosphäre), was etwas über den 14 ° Celsius liegt, die Klimaforscher als mittlere globale Temperatur im vorindustriellen Holozän ermittelt haben.

Die Kurve zeigt das Abfallen der mittleren globalen Temperatur bei einer Transmission von nahe null bis zu eins. Bei eins erhalten wir wieder die -18 Grad Celsius, die wir ohne Atmosphäre hätten. Der Kurvenverlauf zeigt die Empfindlichkeit der globalen mittleren Erdtemperatur von der Transmission τ. Jedoch ist obiger Zusammenhang nur eine Näherung der Wirklichkeit, der aber schon deutlich zeigt, wie der Albedo- und der Transmissionsfaktor auf die Temperatur wirkt. So gibt die obige Gleichung nicht wieder, wie Albedo- und Transmissionsfaktor voneinander abhängen. Denn ganz klar führen höhere Temperaturen zu Eisschmelzen und dieser verringert den Albedofaktor.

Das Modell des thermodynamischen Gleichgewichts zwischen Sonne und Erde, wie es in dieser Analyse verwendet wird, ist eine stark vereinfachte Darstellung des globalen Klimasystems. Es liefert grundlegende Erkenntnisse, ist jedoch in vielerlei Hinsicht limitiert. Hier sind die wichtigsten Limitierungen und Gründe, warum komplexere Klimamodelle notwendig sind:

Das einfache Modell berücksichtigt nicht:

Das Modell arbeitet mit einem globalen Mittelwert:

- Es unterscheidet nicht zwischen den Polen, gemäßigten Zonen oder Tropen, obwohl diese stark unterschiedliche Strahlungsbilanzierungen aufweisen.

- Klimazonen mit spezifischen Eigenschaften (z. B. Wüsten, Regenwälder) bleiben unberücksichtigt.

Das Modell geht von einem sofortigen Gleichgewicht aus. In der Realität benötigen Klimasysteme Jahrzehnte bis Jahrhunderte, um auf Veränderungen zu reagieren (z. B. durch die Wärmekapazität der Ozeane oder die Verweildauer von CO₂ in der Atmosphäre).

Vernachlässigung von Aerosolen und Wolken

- Wolken spielen eine Schlüsselrolle, da sie sowohl reflektierend (kühlend) als auch isolierend (wärmend) wirken können. Ihr Einfluss ist komplex und im einfachen Modell nicht enthalten.

- Aerosole, die durch Vulkane oder menschliche Aktivitäten ausgestoßen werden, beeinflussen die Strahlungsbilanz erheblich, fehlen aber ebenfalls im Modell.

Keine Berücksichtigung von Landoberflächen und Vegetation

- Landoberflächen haben unterschiedliche Reflexions- und Wärmeaufnahme-Eigenschaften (z. B. Schnee, Wälder, Städte).

- Vegetation beeinflusst das Klima durch Evapotranspiration und Kohlenstoffbindung.

Chemische Prozesse und Treibhausgase

- Das Modell berücksichtigt nur CO₂ und ignoriert andere wichtige Klimagase wie Methan (CH₄), Lachgas (N₂O) oder Fluorchlorwasserstoffe (FCKWs).

- Die chemische Dynamik in der Atmosphäre, wie die Bildung und Zersetzung von Ozon, wird nicht modelliert.

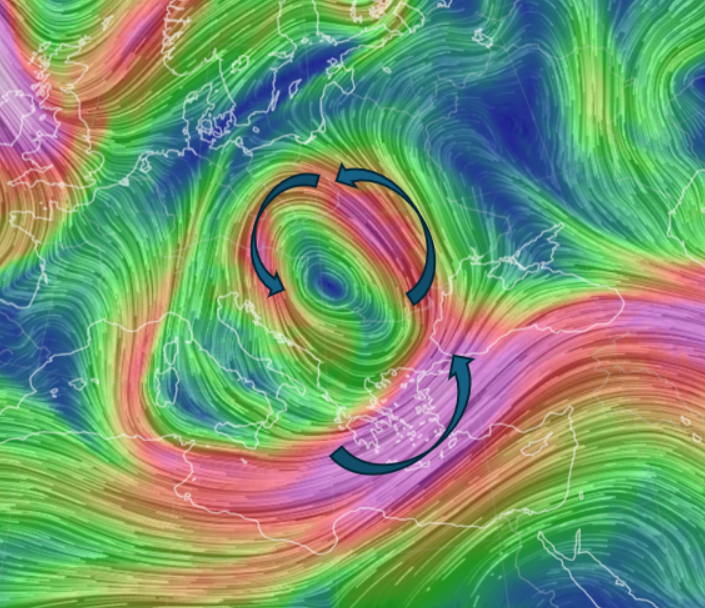

Strömungsmechanik

- Atmosphärische Dynamik: Windsysteme, Konvektion und die Verteilung von Wärme durch Luftströmungen (z. B. Jetstreams).

- Ozeanströme: Der Transport von Wärme durch Strömungen wie den Golfstrom wird komplett ausgelassen. Diese sind entscheidend für die Verteilung von Energie auf der Erde.

- Rückkopplungsmechanismen: Prozesse wie die Eis-Albedo-Rückkopplung, bei der schmelzendes Eis die Absorption von Sonnenstrahlung erhöht, oder die Wasserdampf-Rückkopplung, die den Treibhauseffekt verstärkt, fehlen im Modell.

Komplexe Klimamodelle, sogenannte General Circulation Models (GCMs), sind notwendig, um:

- Räumliche Details zu erfassen:

- Sie simulieren lokale und regionale Unterschiede im Klima.

- Das ist entscheidend für Vorhersagen zu Extremwetterereignissen wie Dürren oder Überschwemmungen.

- Zeitliche Dynamiken zu berücksichtigen:

- Sie modellieren den zeitlichen Verlauf von Veränderungen, z. B. die Verzögerung zwischen CO₂-Anstieg und Temperaturerhöhung.

- Rückkopplungen abzubilden:

- Komplexe Wechselwirkungen wie die Wasser- oder Kohlenstoffzyklen werden integriert.

- Zukünftige Szenarien vorherzusagen:

- Sie ermöglichen die Analyse der Auswirkungen unterschiedlicher Emissionsszenarien (z. B. IPCC-Klimaberichte).

- Extremereignisse zu simulieren:

- GCMs können die Häufigkeit und Intensität von Hitzewellen, Stürmen oder Meeresspiegelanstiegen modellieren.

- Anthropogene Einflüsse zu bewerten:

- Der Einfluss menschlicher Aktivitäten auf die Klimabilanz wird detailliert einbezogen.

Das einfache Modell bietet eine grundlegende Einsicht in die Energiebilanz der Erde und die Bedeutung von Parametern wie Albedo und Treibhauseffekt. Es ist jedoch nicht ausreichend, um die komplexen und dynamischen Prozesse des globalen Klimasystems zu verstehen. Komplexe Klimamodelle sind notwendig, um regionale Unterschiede, Rückkopplungen und zeitliche Entwicklungen zu berücksichtigen und präzise Vorhersagen zu ermöglichen.

Aber auch die wesentlich komplexeren Klimamodelle, die nur mit Hochleistungscloud Computern berechnet werden können, kommen zu keiner wesentlich anderen Kernaussage als:

Wenn die Strahlungstransmission der Erde sich verringert (τ wird kleiner, Treibhauskonzentration wie CO₂ und Methan(CH4) wird größer), steigt die mittlere globale Temperatur T und das auch nicht linear.

Das ist keine graue Theorie, die Wissenschaftler sich ausgedacht haben, um ihre Forschung bezahlt zu bekommen, wie mir einige Menschen in meiner Nachbarschaft auch gerne erzählen, denn man sieht die Prognosen ganz deutlich in den Messdaten. Theorie und Messdaten passen leider bestens zusammen.

Wie kann man sehen, dass es definitiv in den letzten Jahrzehnten auf diesem Planeten wärmer geworden ist? Es gibt global verteilte Messeinrichtungen vom Boden bis ins Weltall. Und diese sind in der Tat in der Lage, einen globalen Temperaturmittelwert zu bilden, “für manche scheint das immer noch erstaunlich zu sein, dass wir so etwas können“.

In der folgenden Abbildung sieht man den globalen Temperaturanstieg von 1880 (erste globale Messungen dokumentiert) bis 2023 gegenüber dem langjährigen Mittel von 1951 bis 1980. Die blauen Punkte entsprechen den tatsächlichen Messwerten, die gestrichelte Linie dem geglätteten Mittelwert dieser Messwerte.

Diese Messungen steigen bis auf den Zeitbereich von 1940 bis 1960 eindeutig an.

(https://climate.nasa.gov/vital-signs/global-temperature/?intent=121)

Zusätzlich wurden auf Dekadenebene die Ausgleichsgrade für die Zeiträume:

- 1940-1960

- 1960-1980

- 1980-2000

- 2000-2020

- 2010-2023

eingezeichnet.

Deutlich fällt auf, dass die Steigungen dieser Ausgleichsgeraden ansteigen. Ein Anstieg der Steigung mit der Zeit bedeutet, dass die Temperatur pro Zeiteinheit beschleunigt anwächst. Wir sehen also schon jetzt ein nicht lineares Temperaturänderungsverhalten bzgl. der Atmosphäre.

Schon jetzt steht fest, dass 2024 wieder wärmer war als das letzte Rekordjahr 2023. Wenn man als Temperaturreferenz den Zeitraum 1880-1900 nimmt, so wird die Temperaturerhöhung im Jahr 2024 mit 1,54 Grad angegeben.

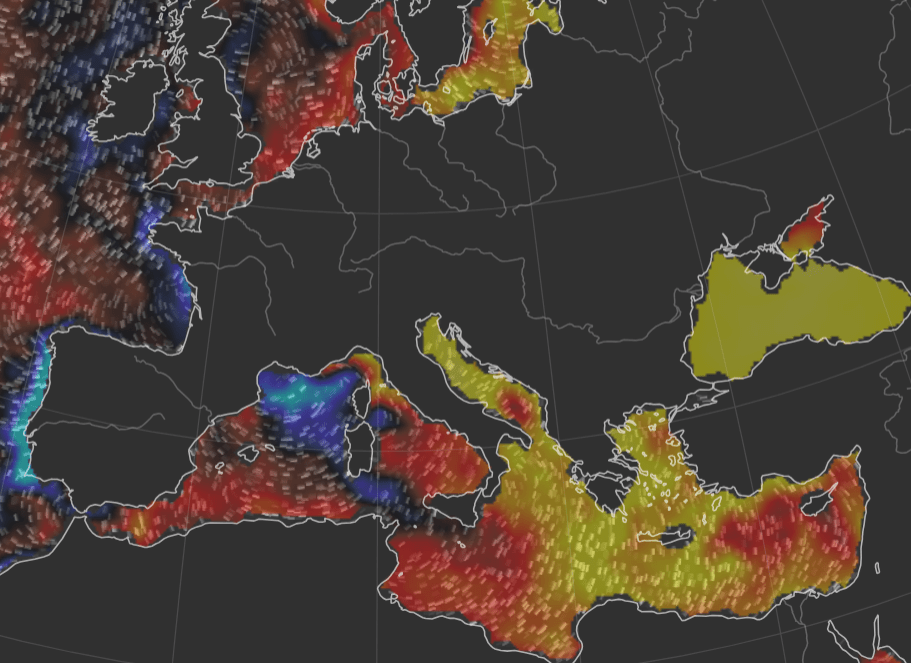

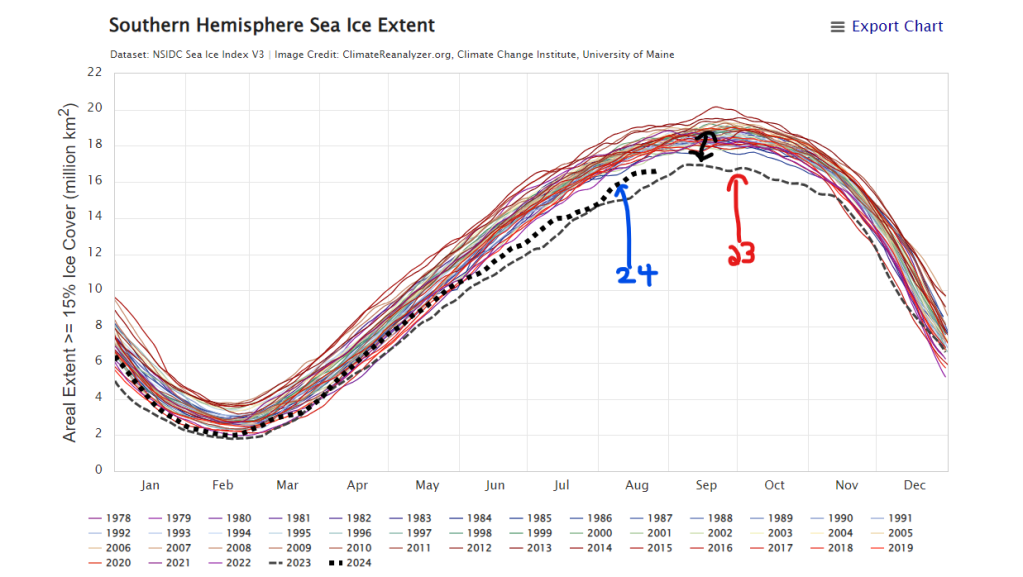

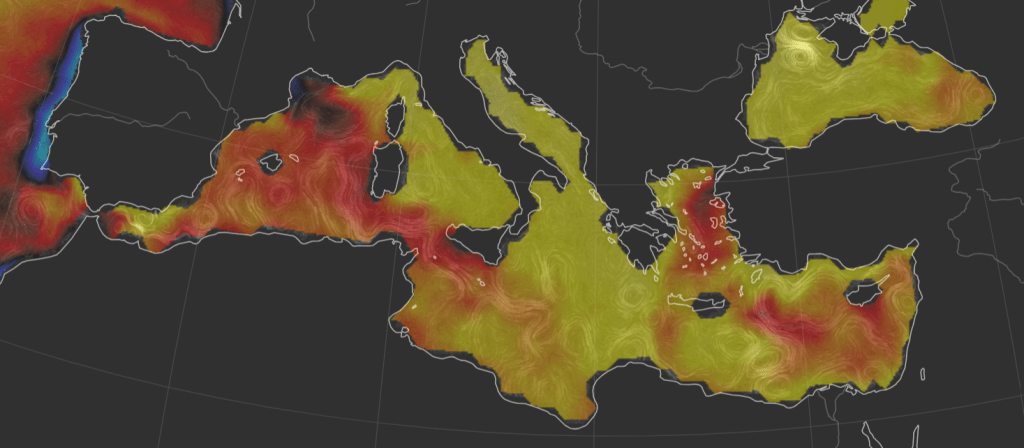

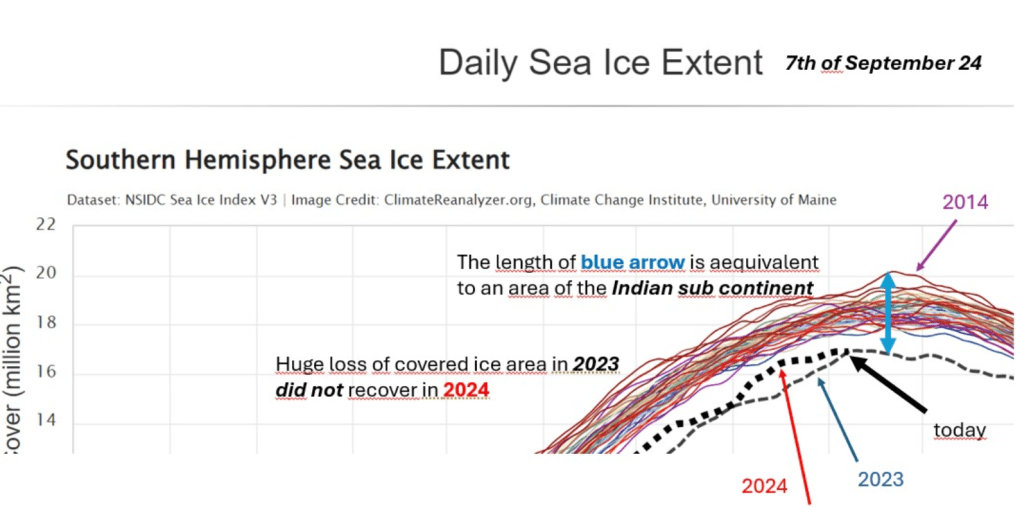

Neben der Erwärmung der Atmosphäre haben sich auch die Ozeane in den letzten Jahren dramatisch erwärmt, mit Rekordtemperaturen in den Jahren 2023 und 2024. Seit März 2023 lagen die durchschnittlichen Oberflächentemperaturen der Weltmeere täglich höher als je zuvor gemessen.

Die Ursachen für diesen abrupten Anstieg der Meerestemperaturen sind bisher nicht vollständig verstanden. Klimawissenschaftler vermuten ein Zusammenspiel mehrerer Faktoren, darunter die vom Menschen verursachte globale Erwärmung durch Treibhausgasemissionen und natürliche Klimaphänomene wie El Niño.

Die Erwärmung der Ozeane hat weitreichende Folgen, darunter Veränderungen der Meeresströmungen, Auswirkungen auf marine Ökosysteme und eine Verstärkung extremer Wetterereignisse. Die genauen Mechanismen hinter dem schnellen Temperaturanstieg werden weiterhin intensiv erforscht, um ein besseres Verständnis und effektive Gegenmaßnahmen zu entwickeln. Die Frage ist, kann man dagegen Gegenmaßnahmen entwickeln?

Eine viel gestellte Frage im Kontext des Klimawandels ist die globale Temperaturerwärmung um 1 Grad, in diesem Jahr schon 1,54 Grad, denn wirklich schlimm beziehungsweise viel? Weiter oben hatte ich ja auch geschrieben, dass der natürliche Treibhauseffekt, die mittlere globale Temperatur von -18 Grad Celsius um 34 Grad auf +16 Grad erhöht (rechnet man genauer, sind es 33 Grad Temperaturerhöhung auf +15 Grad Celsius mittlere Temperatur). Sind denn 1,5 Grad mehr oder weniger überhaupt so entscheidend? Sind wir doch im täglichen Leben Temperaturveränderungen von 5 bis 15 Grad Celsius gewohnt?

Ich nähere mich dieser Frage erst einmal messtechnisch:

Obige Temperaturkurve, die die globale mittlere Temperatur auf der Erde über die letzten 2019 Jahre zeigt, verdeutlicht einen sehr raschen Temperaturanstieg ab 1900 an. Auch für einen Laien wirkt dieser nicht normal. Aber halt, vor 2000 Jahren gab es doch noch kein globales Netz aus Wetterstationen und Satelliten.

Um zu verstehen, wie Wissenschaftler die Temperaturen der Vergangenheit rekonstruieren, nutzen sie eine Art “Zeitkapsel” der Natur: Eisbohrkerne aus der Antarktis. Diese Eiskerne enthalten kleine Luftblasen und Wasser, die wertvolle Informationen über das Klima vor Tausenden Jahren speichern. Aber wie genau funktioniert das?

Die Rolle von Sauerstoff und Wasserstoff im Eis

Das Geheimnis liegt in den winzigen Bausteinen des Wassers – den Atomen. Wasser besteht aus Wasserstoff und Sauerstoff, und diese Elemente gibt es in unterschiedlichen “Sorten”, den sogenannten Isotopen. Besonders wichtig sind Sauerstoff-18 (18O) und Deuterium (2H), ein schwerer Wasserstoff.

Je kälter die Atmosphäre war, als sich das Eis bildete, desto weniger dieser schweren Isotope landeten im Schnee. Wissenschaftler messen das Verhältnis dieser Isotope und können daraus auf die damalige Temperatur schließen. Das ist wie ein Fingerabdruck des Klimas.

Was erzählen die eingeschlossenen Luftblasen?

Im Eis sind winzige Luftblasen eingeschlossen, die die Zusammensetzung der Atmosphäre zur Zeit der Eisbildung bewahren. Wissenschaftler analysieren den Gehalt von Treibhausgasen wie CO₂ und Methan. Diese Gase verraten, ob die Erde damals eher warm oder kalt war, denn es gibt einen engen Zusammenhang zwischen Treibhausgasen und der globalen Temperatur.

So funktioniert die Temperaturmessung:

- Eiskern bohren: Forscher holen einen Zylinder aus Eis aus der Tiefe der Antarktis. Jede Schicht entspricht einer bestimmten Zeit – wie die Jahresringe eines Baumes.

- Isotopen messen: Das Verhältnis der schweren Isotope 18O) und Deuterium (2H) wird untersucht. Je mehr davon, desto wärmer war es damals.

- Luftblasen analysieren: Die Luft aus den Blasen wird auf CO₂ und Methan untersucht, um das Klimabild zu vervollständigen.

- Vergleich mit heute: Wissenschaftler vergleichen die Ergebnisse mit modernen Daten, um die Temperatur der Vergangenheit genau zu berechnen.

Diese Methode gibt uns ein Bild vom Klima lange, bevor es Thermometer oder Wetterstationen gab. Sie zeigt, wie sich die Erde durch natürliche Prozesse verändert hat – und wie stark der Mensch das Klima heute beeinflusst.

Durch diese faszinierende Technik können wir “hören”, was das Eis uns über die Geschichte unseres Planeten erzählt.

Aber das erklärt bisher nicht, warum 1,5 Grad zusätzliche, vom Menschen gemachte, Temperaturerwärmung wirklich viel ist.

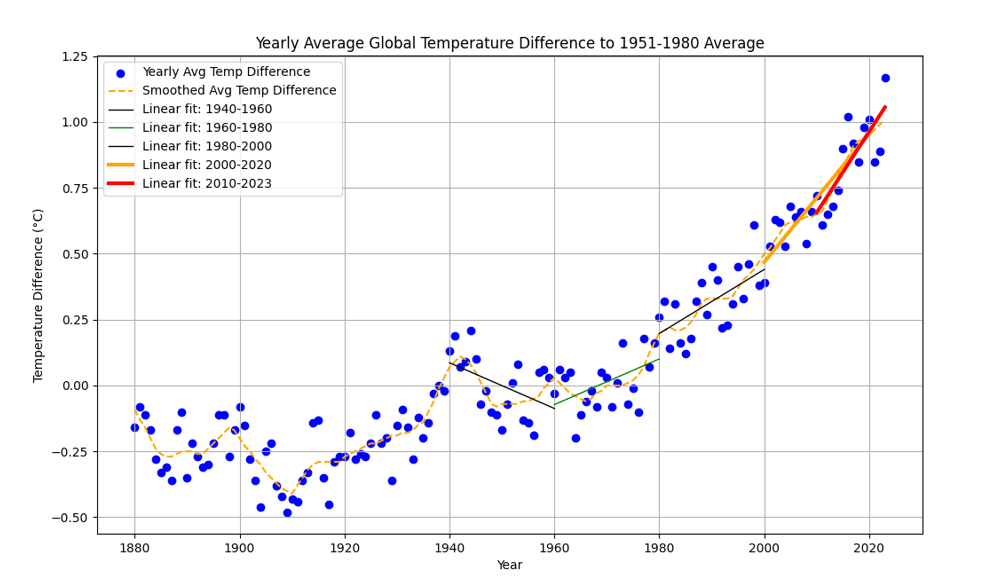

Der sogenannte “Temperature Corridor of Life” beschreibt den engen Temperaturbereich, innerhalb dessen das Leben, wie wir es heute kennen, gedeihen konnte. Die Idee dahinter: Schon kleine Veränderungen der globalen Durchschnittstemperatur können drastische Auswirkungen auf das Klima, Ökosysteme und die Lebensbedingungen auf der Erde haben.

Der Temperatur-Korridor: Eine Reise durch die Erdgeschichte

Wissenschaftler nutzen das Holozän – die letzten etwa 12.000 Jahre, in denen das Klima relativ stabil war – als Referenzlinie. In dieser Zeit entstand die heutige menschliche Zivilisation mit Landwirtschaft, Städten und Technologien. Die Durchschnittstemperatur während des Holozäns bildet den Nullpunkt auf der Temperaturskala.

Auf dieser Skala sehen wir:

- Am unteren Ende: Etwa 6°C kälter als im Holozän. Das war der Zustand während der letzten Eiszeiten, als riesige Gletscher große Teile Europas, Asiens und Nordamerikas bedeckten. Das Leben war hart, große Landmassen waren unbewohnbar, und viele Tierarten überlebten nur knapp.

- Am oberen Ende: Etwa +2°C wärmer als das Holozän. In dieser Richtung wird die Erde immer heißer, was zu katastrophalen Auswirkungen führt: steigender Meeresspiegel, extreme Wetterereignisse und das Risiko, das ganze Ökosysteme kollabieren.

Warum 1,5°C so wichtig sind

Die gesamte Spanne zwischen Eiszeiten und extrem warmen Perioden beträgt etwa 8°C. Klingt vielleicht nach viel, aber wir müssen bedenken:

- Ein Unterschied von nur 6°C brachte uns von eiszeitlichen Gletschern zur heutigen Welt.

- Ein Anstieg von nur 2°C über das Holozän hinaus würde die Erde in eine völlig neue, gefährlich warme Phase katapultieren.

Jetzt wird deutlich, warum 1,5°C Erwärmung so entscheidend ist. Diese scheinbar “kleine” Zahl macht fast 20% der gesamten Temperaturspanne zwischen den Extremen aus. Schon diese Veränderung reicht aus, um Gletscher weltweit schmelzen zu lassen, Ozeane zu erwärmen und Ökosysteme aus dem Gleichgewicht zu bringen.

Ein Beispiel aus der Vergangenheit

Während der letzten Eiszeit war der globale Meeresspiegel etwa 120 Meter niedriger als heute, weil so viel Wasser in Gletschern gebunden war. Diese riesigen Veränderungen entstanden durch eine Abkühlung von “nur” 6°C. Wenn wir uns also vorstellen, was eine Erwärmung von 1,5°C oder sogar 2°C bedeuten könnte, wird klar: Die Auswirkungen wären alles andere als gering.

(https://ecogain.se/app/uploads/2024/05/image.jpeg)

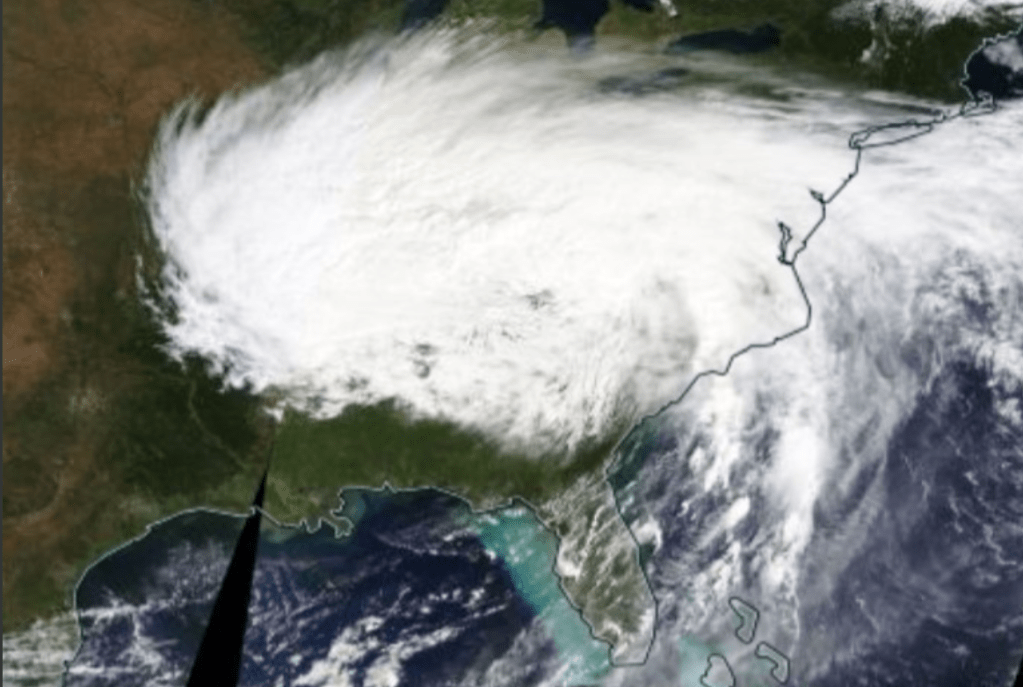

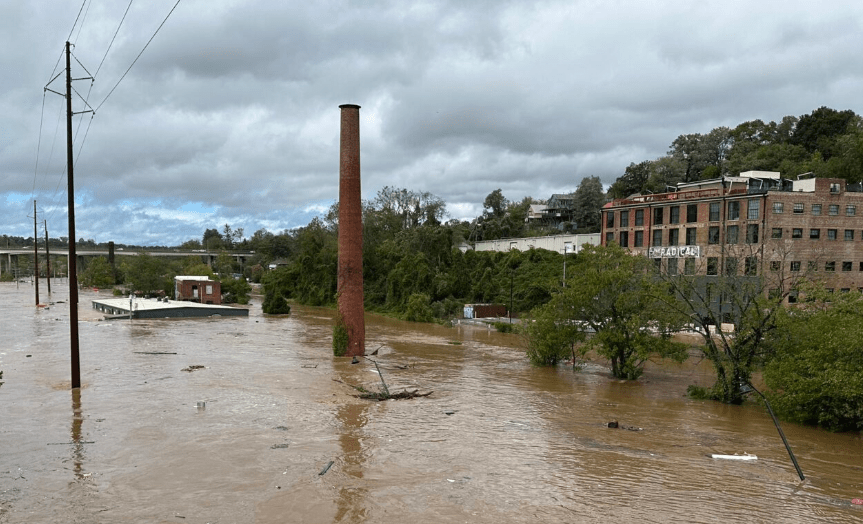

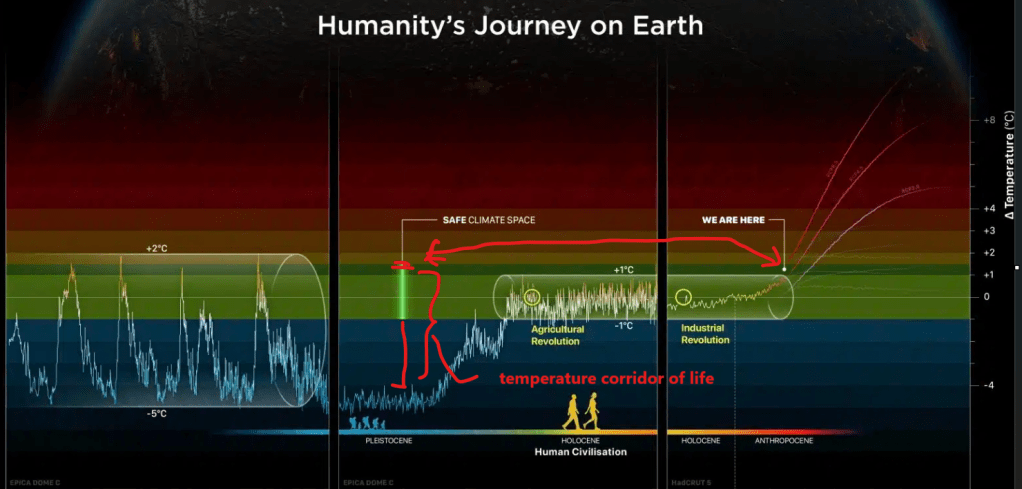

Aber was sind die Auswirkungen dieser beschleunigten Temperaturerhöhung sowohl in der Atmosphäre als auch in den Meeren, die Antwort: Zunahme von Extremwetter in Häufigkeit und Intensität.

Um zu verstehen, warum eine Erwärmung der Atmosphäre zu mehr Überschwemmungen und gleichzeitig zu mehr Dürren führen kann, schauen wir uns die Grundlagen an.

Warme Luft „trinkt“ mehr Wasser: Das Clausius-Clapeyron-Gesetz

Mit jeder Erhöhung der Lufttemperatur um 1°C kann die Atmosphäre etwa 7% mehr Wasser aufnehmen. Das bedeutet:

Wärmere Luft = durstigere Luft: Sie nimmt mehr Wasser aus den Böden, Flüssen, Seen und sogar Pflanzen auf.

Mehr Feuchtigkeit in der Atmosphäre: Das gespeicherte Wasser wird irgendwann in Form von Regen oder Schnee wieder freigesetzt.

Dieser Effekt wird auch als „Dampfhunger der Atmosphäre“ bezeichnet, weil wärmere Luft regelrecht nach mehr Feuchtigkeit “hungert”. Das klingt zunächst harmlos, hat aber weitreichende Folgen.

Was passiert bei mehr Feuchtigkeit in der Atmosphäre?

1. Starke Niederschläge und Überschwemmungen:

Wenn warme, feuchte Luft abkühlt, z. B. weil sie auf kalte Luftmassen trifft, regnet sie das gespeicherte Wasser aus. Und weil die Atmosphäre mehr Feuchtigkeit als früher gespeichert hat, sind die Regenfälle oft extremer.

Ergebnis: Heftige Überschwemmungen, wie wir sie in den letzten Jahren immer häufiger sehen, zuletzt in Valencia (man bewege den horizontalen Schieberegler im unteren Link).

https://www.esa.int/ESA_Multimedia/Images/2024/10/Valencia_flood_disaster

2. Dürre und Blitzdürren:

Warme Luft entzieht Böden und Pflanzen ständig Wasser. Wenn es dann längere Zeit nicht regnet, trocknen Böden und Flüsse schneller aus als früher.

Dies führt zu lang anhaltenden Dürren, aber auch zu sogenannten Blitzdürren: Regionen, die erst grün und fruchtbar waren, trocknen plötzlich innerhalb von wenigen Wochen komplett aus.

Das Wechselspiel von Fluten und Dürren

Diese beiden Effekte – heftiger Regen und schnelle Austrocknung – können sich immer häufiger abwechseln:

Nach einer Dürreperiode saugt der trockene Boden das Wasser bei einem Starkregen nicht mehr richtig auf, was Überschwemmungen verstärkt.

Umgekehrt trocknet der Boden nach einer Überschwemmung bei hoher Temperatur rasant wieder aus, was die nächste Dürre vorbereitet.

Das macht unsere Welt unberechenbarer: Es wird schwieriger, Wasserreserven zu bewirtschaften, die Landwirtschaft zu planen oder sich vor Naturkatastrophen zu schützen.

Aber der Klimawandel hat noch mehr parat als Wetterextreme: Klima Kipppunkte

Kipppunkte von komplexen Systemen sind naturgemäß nicht einfach zu verstehen bzw. zu prognostizieren. Während man das Kippen eines Stuhls recht leicht berechnen kann, ist das bei Geosystemen schon schwieriger. Klar ist jedoch, je wärmer es wird, umso wahrscheinlicher wird es, dass Klimakipppunkte aktiviert werden. Auch deshalb hatte man versucht, im Pariser Klimaabkommen die Erderwärmung auf 1,5 Grad Celsius zu begrenzen. Das hat leider nicht geklappt. Noch ist eine Begrenzung auf 2 Grad Celsius möglich, aber auch das Erreichen dieser Temperaturanstiegsbegrenzung wird immer unwahrscheinlicher.

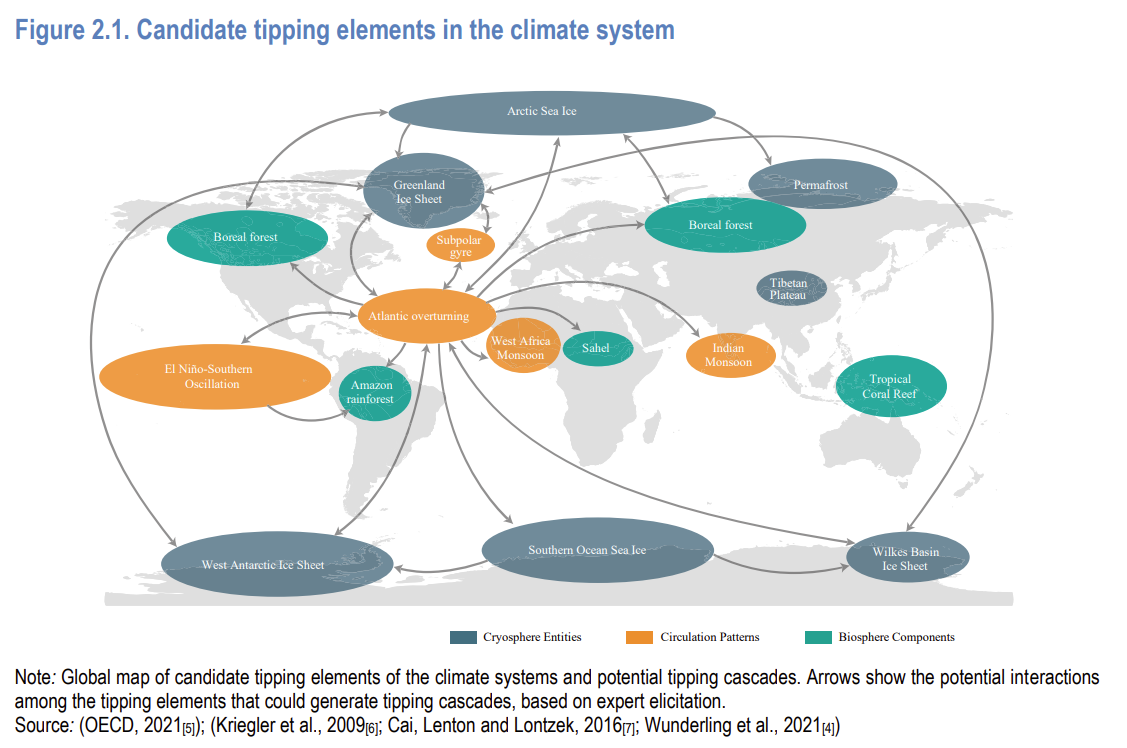

Es folgt eine recht komplexe, aber vollständige Grafik von Geo Subsystemen, die, über die Pfeile angedeutet, miteinander in Verbindung stehen und daher große Kaskadeneffekte mit sich bringen können:

Auf obige Grafik klicken, um die einzelnen Elemente besser zu erkennen (Quelle OECD 2022).

Ich möchte die Komplexität etwas reduzieren, indem ich den Fokus auf den Nordpol, den Grönländischen Eisschild, den Permafrostboden, den AMOC und Amazonas setze.

Trotzdem noch ein kleiner Einschub zum Kipppunkt: “Tropical Corral Reef“.

Viele Wissenschaftler sind sich einig, dass viele Korallenriffe bereits einen Kipppunkt überschritten haben, da häufige Bleiche, steigende Meerestemperaturen und Versauerung ihre Erholung erschweren. Dennoch gibt es Hoffnung: Mit globalem Klimaschutz, lokaler Erhaltung und innovativen Restaurationsmethoden können einige Riffe geschützt und gerettet werden. Jeder vermiedene Grad an Erwärmung erhöht die Chance, Teile dieser Ökosysteme zu bewahren.

Noch muss das obige Bild kein Bild der Vergangenheit sein, aber bei einer Erderwärmung von über 2 Grad Celsius sind 99% der Korallen dem Untergang geweiht.

Nun aber zum Nordpol, der aus meiner Sicht schon in den Dreißigerjahren zu einer großen Kipppunktkaskade führen wird. Wohlgemerkt, das ist eine persönliche Meinung, die ich aus den Daten und Dokumenten der Forschung, zusammen mit meiner persönlichen Lebenserfahrung als Ingenieur, der täglich mit großen Datenmengen arbeitet, herauslese, das heißt aber absolut nicht, dass es so weit kommt, so früh oder in der Kombination, wie von mir skizziert, sondern ich interpretiere die Daten.

Die Wissenschaft sagt aber eindeutig, dass wir derzeit auf dem Weg von 2,7 Grad Erderwärmung gegenüber vorindustriellem Niveau sind (https://academic.oup.com/bioscience/advance-article/doi/10.1093/biosci/biae087/7808595?login=false). Bei dieser Entwicklung können wir sehr sicher sein, dass eine gefährliche Kipppunktkaskade auftritt.

Die Erwärmung des Nordpols verläuft viermal so schnell wie im globalen Mittel. Zu sehen an dieser Grafik:

https://www.nature.com/articles/s43247-022-00498-3

Bei dieser Grafik lassen Sie sich nicht irritieren, dass die Startskalierung bei -1 Grad Celsius liegt. Diese kommt durch die Skalierung von lokalen (Nordpol) und globalen Daten zustande.

Die kräftigen Farben sind verschiedene wissenschaftliche Messdaten. Im Gegensatz dazu sind mit schwach grau-bräunlichen Farben die globale Temperaturerhöhung eingezeichnet. Vergleicht man die Steigung der Ausgleichsgeraden der Nordpolerwärmung zur globalen Erwärmung, so erhält man einen Faktor 3,8.

Wie kommt es dazu, dass der globale Temperaturanstieg am Nordpol fast viermal so stark ist wie im Rest der Welt?

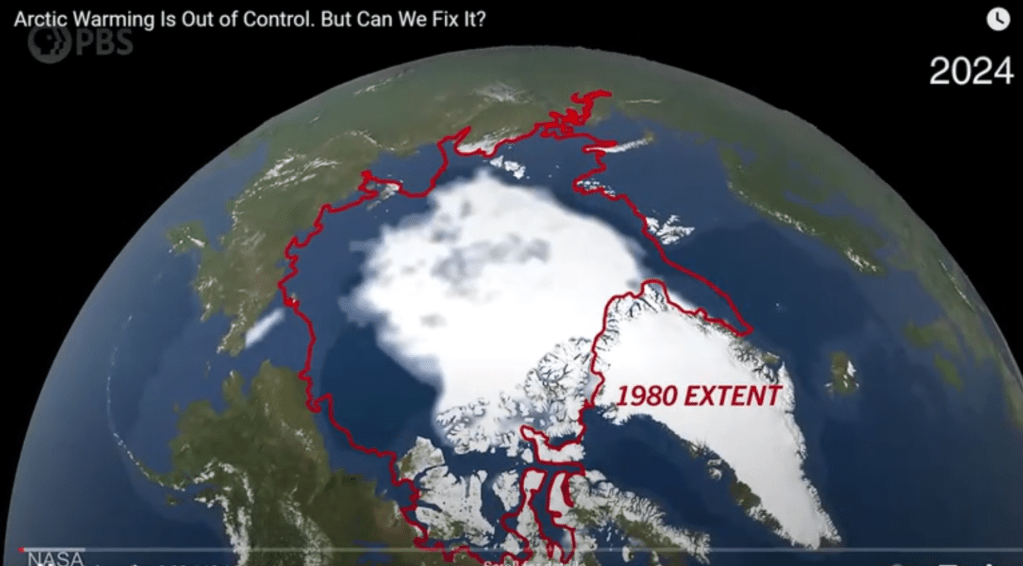

So sah der Nordpol im Sommer die letzten zwölftausend Jahre bis 1980 aus:

Er trug auch im Sommer der Nordhalbkugel mit einem großen Teil zum Albedo-Faktor alpha von ca. 30 % bei, zusammen mit den Gletschern. Doch ab den 80ern stieg die Temperatur der Atmosphäre und der Meere an. Da der Nordpol ein großer Eiswürfel ist, wird seine Substanz von allen Seiten bei Erwärmung angegriffen. Eine Reduktion des Eises führt aber sofort zu einem positiven/verstärkenden Feedback, da das dunkle Meer nahezu vollständig das ankommende Energiespektrum der Sonneneinstrahlung absorbiert.

Deswegen sollte es nicht verwundern, dass der heutige Nordpol im Sommer so aussieht:

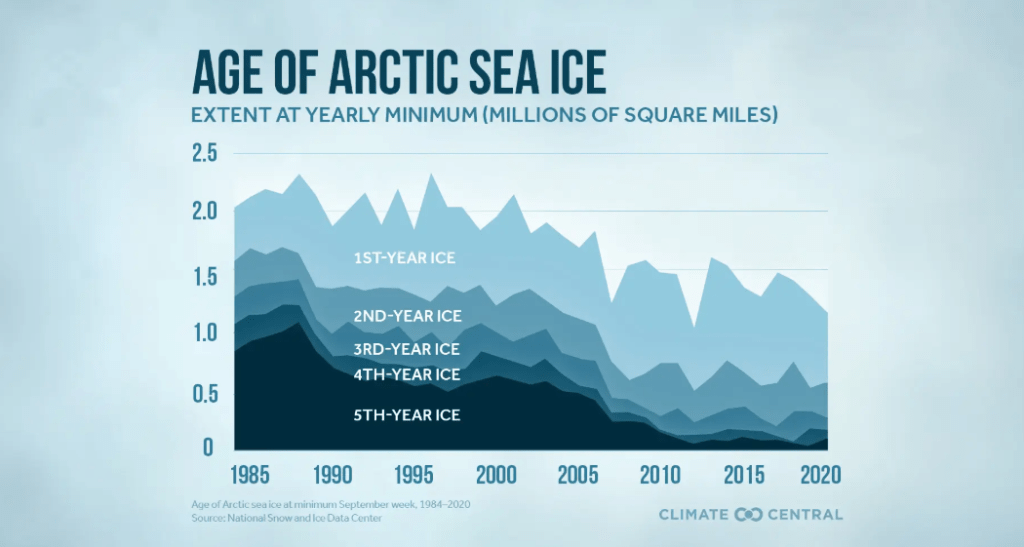

Drastisch ist die Abnahme seit Beginn des 21. Jahrhunderts. Wie viel Eis aber wirklich fehlt, kann man am folgenden Diagramm sehen:

https://www.climatecentral.org/climate-matters/arctic-sea-ice-minimum

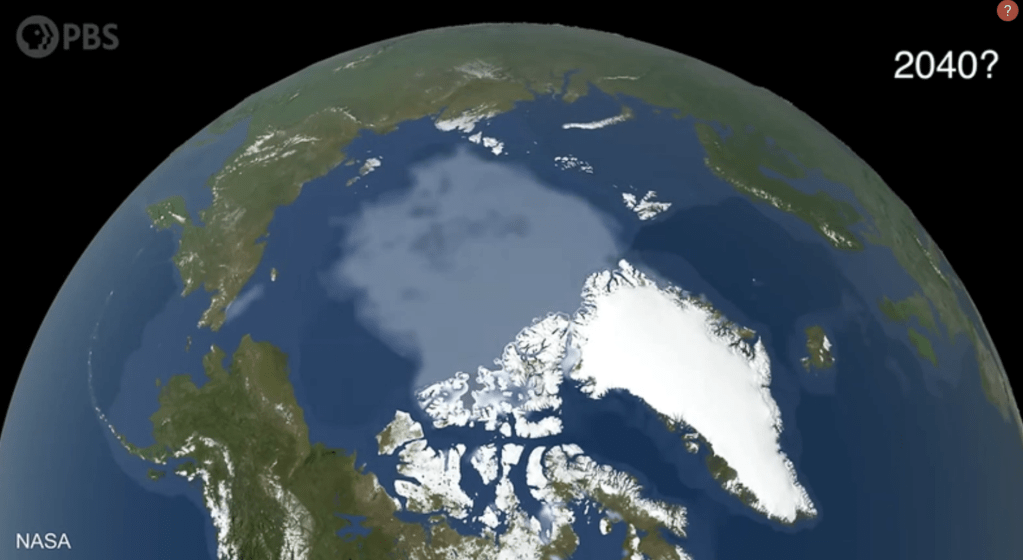

Wie man deutlich erkennen kann, ist das fünf- und vierjährige Eis nahezu verschwunden. Aber auch das ein- bis zweijährige Eis ist auf dem Rückzug. Die Mehrheit der Klimaforscher geht daher davon aus, dass der Nordpol im Sommer 2040 so aussieht:

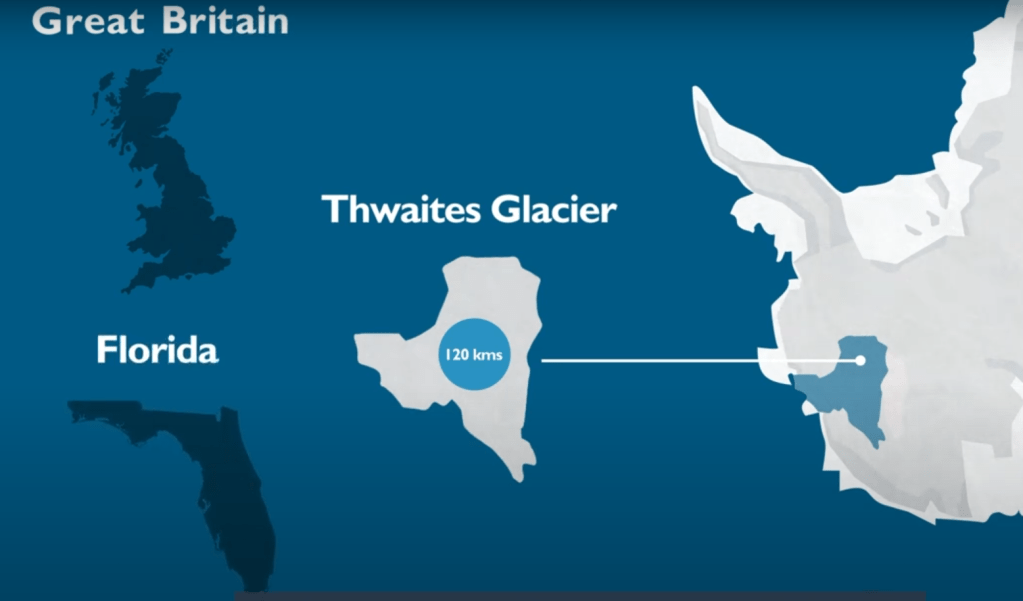

Es gäbe dann noch Eis, aber dieses wäre so dünn, dass schon normale Schiffe (einer gewissen Größe) ohne Probleme die Nordwestpassage passieren könnten. Dieser Nordpol-Zustand wird von den Klimaforschern als “Blue Ocean” Event bezeichnet.

Hinter dem Jahr 2040 steht ein Fragezeichen, natürlich kann man so ein Ereignis nicht auf Punkt und Komma genau vorhersehen. Aber es gibt Wissenschaftler, die dieses Event auch schon früher in den Dreißigern sehen.

Das sogenannte Blue Ocean Event, also der Zeitpunkt, an dem die Arktis im Sommer komplett eisfrei ist, könnte laut neuesten Erkenntnissen bereits in den 2030er-Jahren eintreten, weil die Arktis sich viel schneller erwärmt als der Rest der Welt und dadurch das Eis rasanter schmilzt, als es viele frühere Berechnungen vermuteten. Wissenschaftler haben festgestellt, dass Klimamodelle den Eisverlust bisher unterschätzten, und nachdem sie reale Messdaten von Satelliten und anderen Beobachtungen der letzten Jahrzehnte genutzt haben, um ihre Vorhersagen anzupassen, zeigt sich, dass der Treibhauseffekt, vor allem durch CO₂-Emissionen, der Hauptgrund für das Jahr-für-Jahr zunehmende Schmelzen ist, das nicht nur den Sommer, sondern alle Monate betrifft, was bedeutet, dass selbst bei einer starken Reduzierung der Emissionen das Sommer-Eis in der Arktis bald der Vergangenheit angehören könnte – ein Ereignis, das weitreichende Folgen für Wetterextreme, Meeresspiegel und Ozeanströmungen haben wird und uns zeigt, wie dringend wir eigentlich handeln müssten.

https://www.nature.com/articles/s41467-023-38511-8

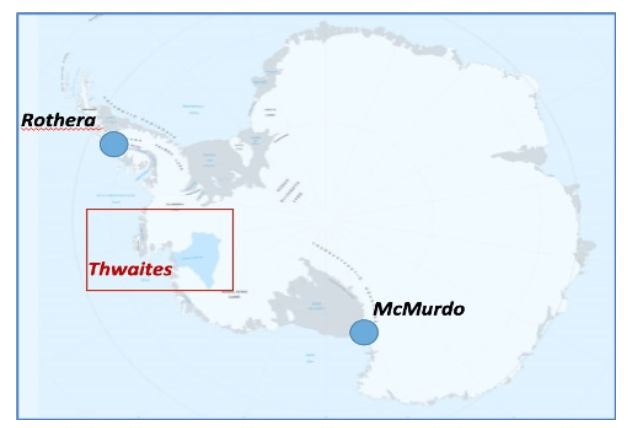

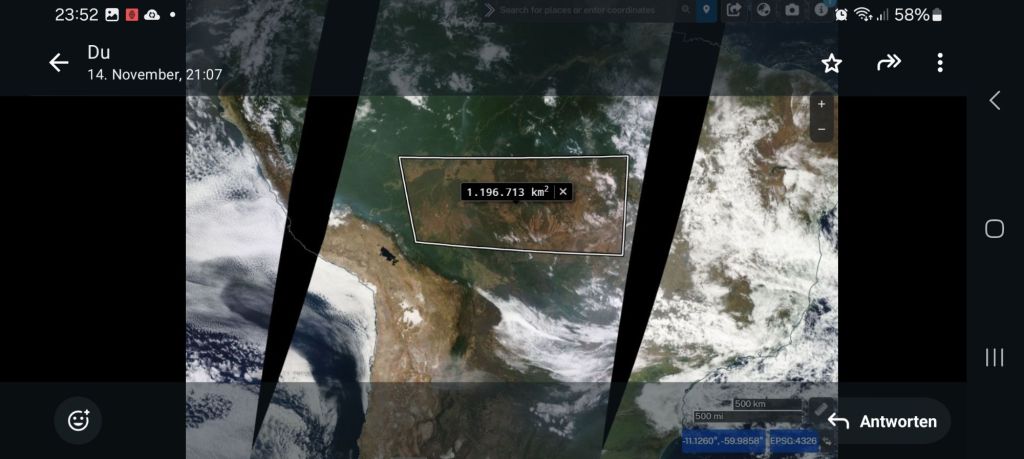

Als Ingenieur muss ich vom Worst Case ausgehen, also nehme ich an, dass Anfang der Dreißiger es so weit ist. Der jetzt schon abtauende Permafrost, wird noch einmal stärker in diesem Vorgang angetrieben. Wir sprechen von dieser Region:

Die im Frost frei werdende biologische Substanz zersetzt sich und es werden weitere zusätzliche Mengen an Methan frei. Methan ist ungefähr ein 20 fach potenteres Treibhausgas als CO₂, wenn auch nicht so langlebig in der Atmosphäre wie CO₂. Auch wenn die Wissenschaft nicht davon ausgeht, dass das Methan aus dem Permafrost explosionsartig in die Atmosphäre tritt, könnte es ausreichen, das Abschmelzen des Eispanzers von Grönland nochmals zu steigern.

Seit dem Jahr 2000 hat Grönland etwa 1.500 Kubikkilometer Eis verloren.Der Bodensee fasst rund 48,5 Kubikkilometer Wasser. Teilt man das geschmolzene Grönlandeis durch das Volumen des Bodensees, ergibt sich, dass man den Bodensee etwa 31-mal mit dem geschmolzenen Eis füllen könnte (Tendenz steigend).

Neben dem signifikanten Problem, dass durch das Schmelzwasser Grönlands der Meeresspiegel steigt, gibt es eine weitere Verkettung von Problemen.

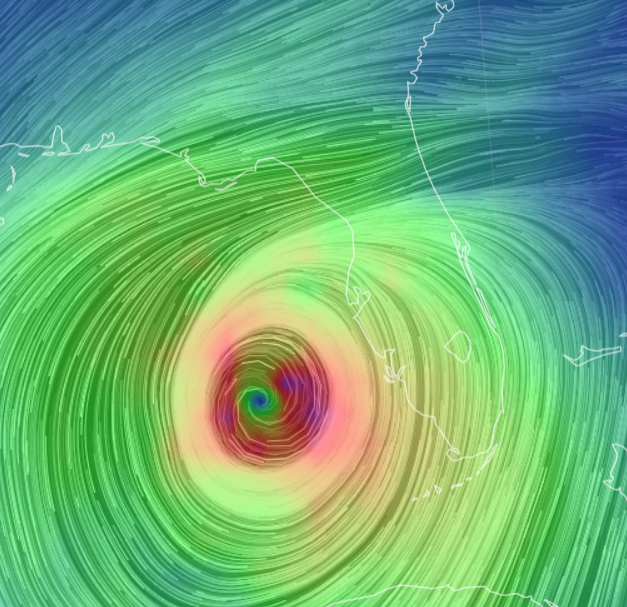

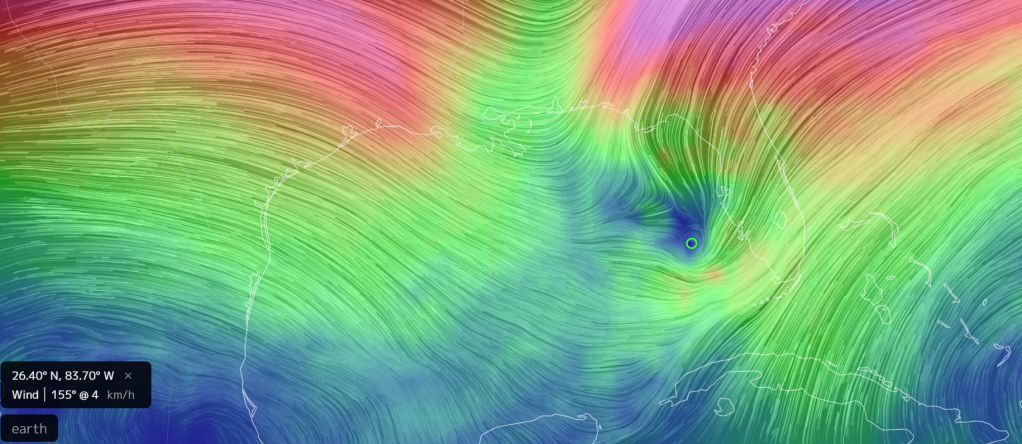

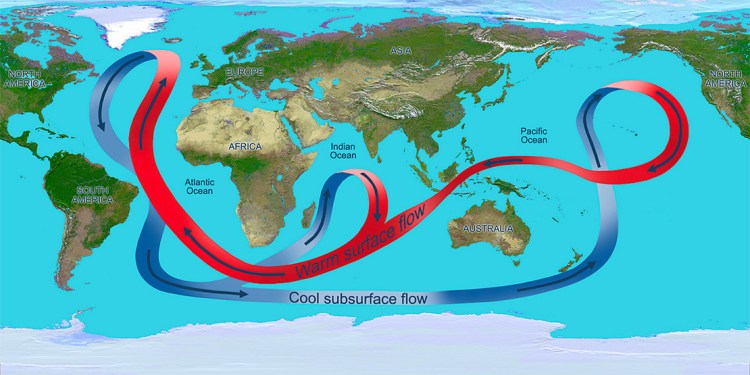

Ein schnelleres Abschmelzen des Grönlandeises wird die Abschwächung der Atlantischen meridionalen Umwälzzirkulation (AMOC), also des Golfstrom-Systems, verstärken. Das wird dramatische Folgen für die Niederschlagsmuster im Amazonasgebiet haben, da dieses globale Strömungssystem entscheidend für die Verteilung von Wärme und Feuchtigkeit auf unserem Planeten ist. Der AMOC transportiert warmes Wasser aus den Tropen nach Norden und treibt so die Temperaturunterschiede an, die für viele Wettermuster verantwortlich sind. Durch das viele Süßwasser verringert sich jedoch die Dichte des Wassers, die benötigt wird, um den Druck für die Wärmepumpe im arktischen Bereich aufzubauen, und genau aus diesem Grund hat sich westlich der britischen Inseln der Cold Blob entwickelt, von dem zu Beginn die Rede war. Die Wärmepumpe schwächelt und warmes Wasser aus den Tropen stockt in Höhe der nördlichen Ostküste der USA und Kanadas

Wenn der AMOC schwächer wird, kühlt der tropische Atlantik auf der Nordhalbkugel ab, was eine Verschiebung der sogenannten Intertropischen Konvergenzzone (ITCZ) nach Süden zur Folge hätte.

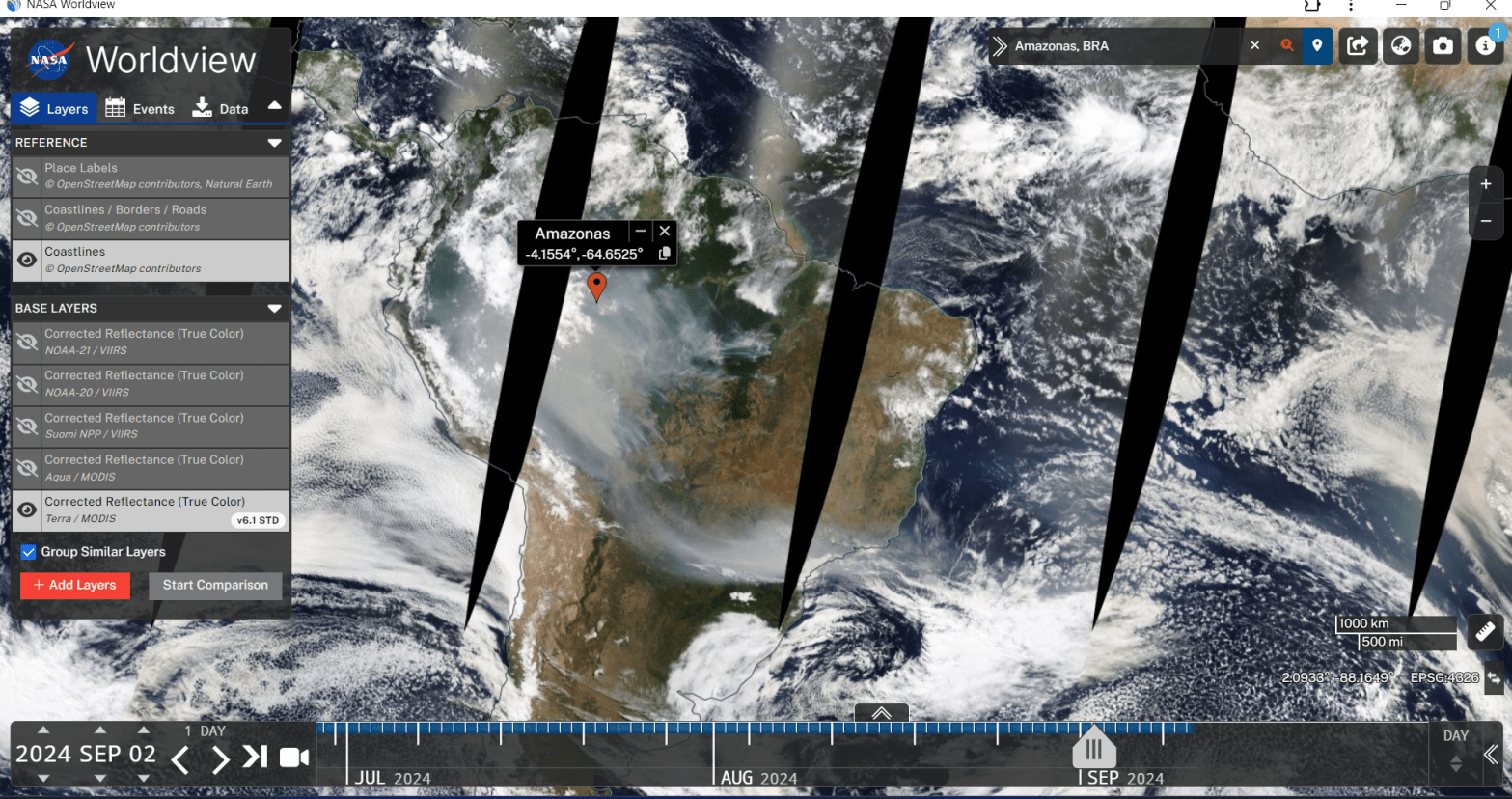

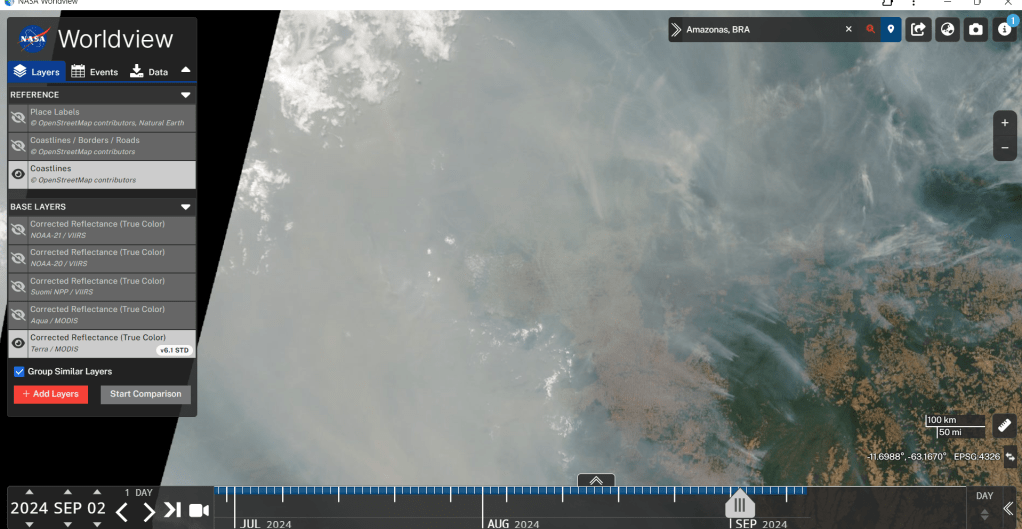

Diese Zone ist ein wichtiges Wettersystem, das starke Regenfälle in den Tropen erzeugt. Eine südliche Verschiebung würde dazu führen, dass der Amazonas weniger Niederschlag erhält, was die Region anfälliger für Trockenheit und Dürre macht. Bereits heute beobachten Forscher häufigere Trockenperioden im Amazonas (ganz aktuell in diesem Jahr), die durch globale Klimaveränderungen verstärkt werden.

Eine solche Entwicklung wäre nicht nur für die lokale Pflanzen- und Tierwelt verheerend, sondern hätte auch globale Auswirkungen, da der Amazonas eine zentrale Rolle im Kohlenstoff- und Wasserkreislauf spielt. Weniger Regen bedeutet weniger Wachstum der Wälder, was wiederum dazu führen könnte, dass der Amazonas von einem CO₂-Speicher zu einer CO₂-Quelle wird – ein Effekt, der den Klimawandel weiter beschleunigen würde.

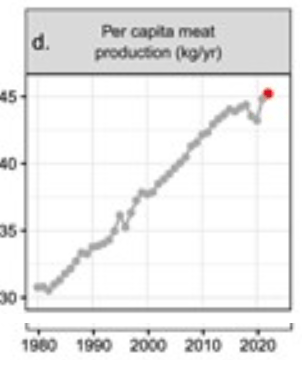

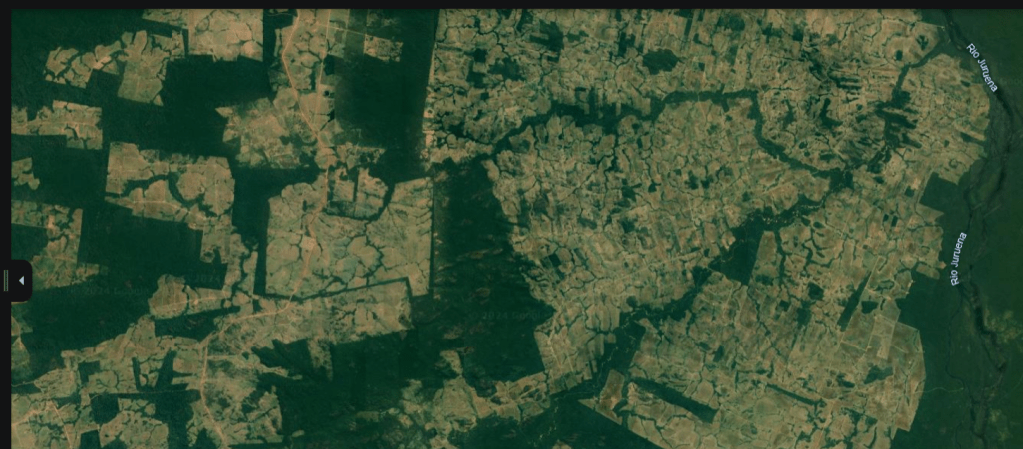

Hinzu kommt, dass der Amazonas seit Jahrzehnten von Brandrodung erfasst ist. Seit den 1970er-Jahren werden im Amazonasgebiet großflächig Wälder durch Brandrodung zerstört, eine Praxis, die mit der Erschließung der Region durch Straßenbau und staatliche Besiedlungsprogramme begann. Damals wurde gezielt Land gerodet, um Platz für Viehzucht, Landwirtschaft und Bergbau zu schaffen, oft gefördert durch staatliche Anreize. Ein Großteil der heutigen Brandrodungen ist jedoch illegal: Holzfäller, Landwirte und Unternehmen brennen Wälder ab, um Land unrechtmäßig zu nutzen, meist für Sojaanbau oder Viehweiden. Gleichzeitig gibt es auch staatlich erlaubte Rodungen, die unter bestimmten Bedingungen legalisiert werden. In den letzten Jahren haben gelockerte Umweltgesetze und mangelnde Kontrolle die illegale Entwaldung zusätzlich beschleunigt. Diese Mischung aus illegalen und staatlich tolerierten Rodungen hat zu einer massiven Zerstörung des Regenwaldes geführt, mit verheerenden Folgen für Klima, Artenvielfalt und die Menschen vor Ort. Der Amazonas, einst ein globaler CO₂-Speicher, wird zunehmend zur CO₂-Quelle. 20 % der ursprünglichen Amazonas-Bewaldung sind schon zerstört. Ab 25% geht die Wissenschaft davon aus, dass ein unabwendbarer Kipppunkt vom Tropenwald zur Savanne abläuft.

Weitere Quellen:

Ich fasse noch einmal zusammen, was ich glaube, was in den nächsten zehn Jahren ablaufen wird:

Der Nordpol könnte schon in den Dreißigerjahren eine Kipppunktkaskade auslösen. Seine Erwärmung verläuft viermal schneller als im globalen Mittel, da schmelzendes Eis dunklere Flächen freilegt, die mehr Sonnenenergie aufnehmen. Seit Beginn des 21. Jahrhunderts sind dicke Eisschichten drastisch geschrumpft, und bis 2040 oder früher könnte der Nordpol im Sommer eisfrei sein.

Das Auftauen von Permafrost setzt Methan frei, ein Treibhausgas, das das Schmelzen von Grönlandeis beschleunigt. Seit 2000 hat Grönland etwa 1.500 Kubikkilometer Eis verloren – genug, um den Bodensee über 30 Mal zu füllen. Dies führt zu steigendem Meeresspiegel und schwächt den Golfstrom (AMOC), der für globale Wärme- und Feuchtigkeitsverteilung entscheidend ist.

Eine Abschwächung des AMOC verschiebt Niederschlagsmuster und könnte im Amazonasgebiet vermehrt Dürren auslösen. Der Regenwald verliert bereits seit den 1970er-Jahren massiv Fläche durch Brandrodung; 20 % sind zerstört. Ab 25 % droht ein Kipppunkt, der den Amazonas in eine Savanne verwandelt – mit verheerenden Folgen für Artenvielfalt und Klima. Es bleibt wenig Zeit, diese Entwicklung zu stoppen.

Die Auswirkungen einer solchen Entwicklung sind nicht in Worte zu fassen, deswegen lasse ich es. Aber dieses beigefügte YouTube-Video bringt es relativ gut auf den Punkt:

Dann könnte mein Sohn doch wieder viel Schnee in Düsseldorf erleben, aber ich denke, so stark hat er den Schnee dann doch nicht vermisst.

Ich glaube aber nicht, dass die Menschheit durch eine solche Entwicklung vollständig zerstört wird, wie der Titel des Blogs andeutet. Die Physikerin Sabine Hossenfelder hatte dazu eine einfache Begründung: “Wir sind einfach schon zu viele!”

Aber wie lange wird die Menschheit mit der Klimakrise noch beschäftigt sein?

Nehmen wir noch ein gutes Szenario an, wo wir die Erwärmung auf +2 Grad einbremsen können.

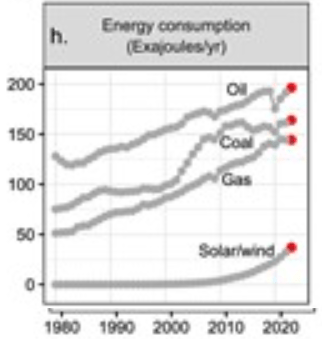

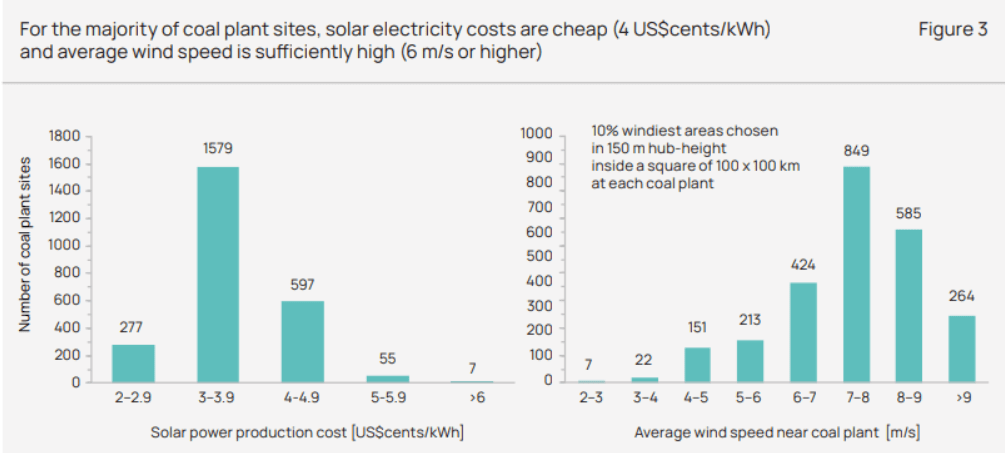

Bis 2030 müssten die weltweiten CO₂-Emissionen um 25 % im Vergleich zu den Werten von 2010 reduziert werden. Das bedeutet, dass innerhalb weniger Jahre enorme Einsparungen durch den Ausstieg aus fossilen Energieträgern, die Umstellung auf erneuerbare Energien und die Einführung effizienterer Technologien erreicht werden müssten. Ohne diese Einsparungen wäre das Zwei-Grad-Ziel unerreichbar.

Langfristig, bis 2070, wird angestrebt, die Klimaneutralität zu erreichen. Klimaneutralität bedeutet, dass alle verbleibenden Emissionen durch entsprechende Gegenmaßnahmen ausgeglichen werden, etwa durch Aufforstung oder technische CO₂-Entfernungsprozesse wie Direct Air Capture (DAC). Dieses Ziel setzt voraus, dass sowohl Staaten als auch Unternehmen umfassend handeln und Technologien entwickeln, um Emissionen zu vermeiden oder zu kompensieren.

Selbst wenn diese ambitionierten Ziele erreicht werden, wird die Konzentration von CO₂ in der Atmosphäre weiter ansteigen. Derzeit liegt die Konzentration bei etwa 420 ppm (Teile pro Million). Aufgrund des bisherigen Emissionsniveaus und der langsamen natürlichen Abbauprozesse von CO₂ in der Atmosphäre steigt der Wert jedes Jahr um 2 bis 3 ppm. Wenn dieser Trend bis 2070 anhält, könnte die CO₂-Konzentration bis dahin auf etwa 514 ppm ansteigen.

Wenn die Welt bis 2070 klimaneutral wird, steigt die CO₂-Konzentration nicht mehr durch menschliche Emissionen, sondern bleibt nahezu stabil. Die verbleibende Zunahme könnte durch natürliche Prozesse (z. B. Rückkopplungen wie die Erwärmung der Böden oder Meere) etwa 0,5–1 ppm pro Jahr betragen. Über die nächsten 30 Jahre (2070 bis 2100) würde dies bedeuten:

0,5 ppm/Jahr x 30 Jahre = 15 ppm

Dadurch würde die Konzentration im Jahr 2100 auf etwa:

514 ppm + 15 ppm = 529 ppm

steigen.

=======================================================================

Einschub: Im sechsten Sachstandsbericht (AR6) des Weltklimarats (IPCC) wird die CO₂-Konzentration von 450 ppm in mehreren Kapiteln thematisiert.

Insbesondere im Kapitel 5 des Berichts der Arbeitsgruppe I wird auf historische CO₂-Konzentrationen und deren klimatische Auswirkungen eingegangen.

Dort wird erwähnt, dass während des mittleren Pliozäns (vor etwa 3,3 bis 3,0 Millionen Jahren) die atmosphärische CO₂-Konzentration zwischen 350 und 450 ppm lag, was mit signifikant höheren globalen Temperaturen und Meeresspiegeln verbunden war.

Diese historischen Daten unterstreichen die potenziellen Risiken, die mit einem Anstieg der CO₂-Konzentration auf vergleichbare Werte in der heutigen Zeit verbunden sind.

Die obige Grafik zeigt, dass es vor 3 Millionen Jahren das letzte Mal eine CO₂-Konzentration von über 400 ppm gab.

==========================================================================

Der Abbau des überschüssigen CO₂ aus der Atmosphäre ist ein langsamer und komplexer Prozess, der uns vor immense Herausforderungen stellt. Die verschiedenen natürlichen Mechanismen arbeiten auf unterschiedliche Weise und Zeiträume hinweg, aber gemeinsam ist ihnen eines: Sie reichen nicht aus, um die durch den Menschen verursachten Emissionen kurzfristig zu neutralisieren.

Die Meere sind die schnellsten Helfer, doch ihre Kapazität ist begrenzt. An der Oberfläche nehmen sie CO₂ auf und wandeln es in chemische Verbindungen um, die in tieferen Wasserschichten gespeichert werden können. Dieser Prozess dauert Jahrzehnte bis Jahrhunderte, während die Versauerung des Wassers die ökologischen Systeme bedroht. Algen in den oberen Wasserschichten nehmen ebenfalls CO₂ auf und transportieren es nach ihrem Absterben in die Tiefsee. Auch dies ist ein langwieriger Vorgang, der über Jahrhunderte wirkt. Die Tiefsee selbst speichert Kohlendioxid über Tausende von Jahren, doch der Fluss des Wassers dorthin ist quälend langsam. Trotz all dieser Mechanismen bleibt ein großer Teil des überschüssigen CO₂ in der Atmosphäre.

Gesteine, insbesondere Kalkstein und Silikate, arbeiten über geologische Zeiträume. Chemische Verwitterung bindet CO₂, indem es mit Gesteinen reagiert und stabile Verbindungen wie Karbonate bildet. Diese Prozesse benötigen jedoch Jahrtausende bis Millionen Jahre, um signifikante Mengen an CO₂ zu entfernen. Meeresorganismen tragen ebenfalls zur CO₂-Speicherung bei, indem sie es in ihre Schalen einbauen. Nach ihrem Tod sinken diese auf den Meeresboden und bilden Kalkstein – eine Form der Speicherung, die über Millionen Jahre stabil bleibt. Doch diese Mechanismen sind so langsam, dass sie keine kurzfristige Entlastung bieten.

Pflanzen und Böden sind oft die Ersten, an die wir denken, wenn es um CO₂-Reduktion geht, aber ihre Kapazität ist stark begrenzt. Bäume und andere Pflanzen nehmen CO₂ durch Fotosynthese auf und speichern es in ihrer Biomasse. Doch wenn die Pflanzen sterben, verrotten oder verbrannt werden, wird das gespeicherte CO₂ wieder freigesetzt. Böden speichern ebenfalls Kohlenstoff aus abgestorbenen Pflanzenresten, doch dieser Speicher ist instabil und von der Landnutzung abhängig. Nachhaltige Landwirtschaft kann diesen Prozess unterstützen, doch die Wirkung bleibt auf Jahrzehnte bis Jahrhunderte beschränkt.

Wenn wir all diese Mechanismen betrachten, wird klar, dass sie unterschiedliche Zeiträume und Kapazitäten haben. Die Meere können innerhalb von Jahrzehnten bis Jahrtausenden große Mengen an CO₂ aufnehmen, doch ihre Kapazität ist begrenzt. Gesteine bieten eine langfristige Lösung, benötigen jedoch Millionen Jahre. Pflanzen und Böden können kurzfristig helfen, doch ihre Speicher sind begrenzt und von menschlichen Eingriffen abhängig. Diese Langsamkeit und Begrenztheit stellen eine ernüchternde Realität dar: Der Abbau des durch uns verursachten überschüssigen CO₂ ist eine Herausforderung, die in dieser Form Zeitskalen betrifft, für die Menschen keine Erfahrung haben.

Ausdrücklich warne ich vor Geo-Engineering, aber ich befürchte, es wird getan. Warum warne ich vor Geo-Engineering? Weil, wenn man einmal damit anfängt, darf man nie mehr damit aufhören.

Sigmund Freud: „Die Stimme der Vernunft ist leise, doch sie ruht nicht, ehe sie sich Gehör verschafft hat.“

Sigmund Freud, der Begründer der Psychoanalyse, betont hier die leise, aber beharrliche Natur der Vernunft. Trotz ihrer anfänglichen Schwäche setzt sie sich letztlich durch. Dieses Zitat unterstreicht Freuds Überzeugung, dass rationale Überlegungen und intellektuelle Einsichten, obwohl sie möglicherweise nicht sofort Beachtung finden, schließlich Anerkennung erlangen. Es reflektiert seine Sicht auf die menschliche Psyche, in der das Bewusstsein und die Vernunft eine entscheidende Rolle spielen, um unbewusste Triebe und Impulse zu verstehen und zu kontrollieren.

Für einen einzelnen Menschen ist Freuds Aussage aus meiner Sicht schon richtig, aber bei acht Milliarden Menschen erweist sich die Vernunft als wirkungslos?

Wir hätten Hoimar von Ditfurth richtig zuhören sollen

Meine Hoffnung jedoch ist, dass die Menschheit auf ihrer langen Reise zu 280 ppm ihre Perspektive zur Natur wieder ändert und auf Augenhöhe mit ihr redet und nicht sie zu einer reinen Ressourcenquelle degradiert.

Fatal hat sich die christliche Interpretation aus dem Buch Genesis Vers 1-28 erwiesen:

“Seid fruchtbar und mehret euch, füllet die Erde und macht sie euch untertan; herrscht über die Fische im Meer, über die Vögel des Himmels und über alle Tiere, die sich auf der Erde regen.”

In den kommenden tausenden Jahren kann der Mensch, “die Krönung der Schöpfung” beweisen, ob er sich eingliedern kann in das Gefüge der Natur und somit erkennt, dass er nicht über ihr steht.